В наше время, когда интернет доступен практически в любой момент, иногда возникает необходимость скачать сайт целиком. Зачем это нужно? Причины могут быть разные: и желание сохранить важную информацию на будущее, и необходимость получить доступ к нужным данным при отсутствии доступа в сеть, и возможность ознакомиться с тем, как сверстаны страницы. Могут быть и другие резоны. Важно знать, как выполнить эту задачу, и далее мы покажем несколько способов как сделать копию сайта для последующего его использования в оффлайн режиме.

Содержание

- Способ 1. Постраничное сохранение

- Способ 2. Использование онлайн-сервисов

- Site2Zip.com

- Webparse.ru

- Другие ресурсы

- Способ 3. Специализированные программы

- WinHTTrack WebSite Copier

- Cyotek WebCopy

- Teleport Pro

- Offline Explorer

- Webcopier

- Заключение

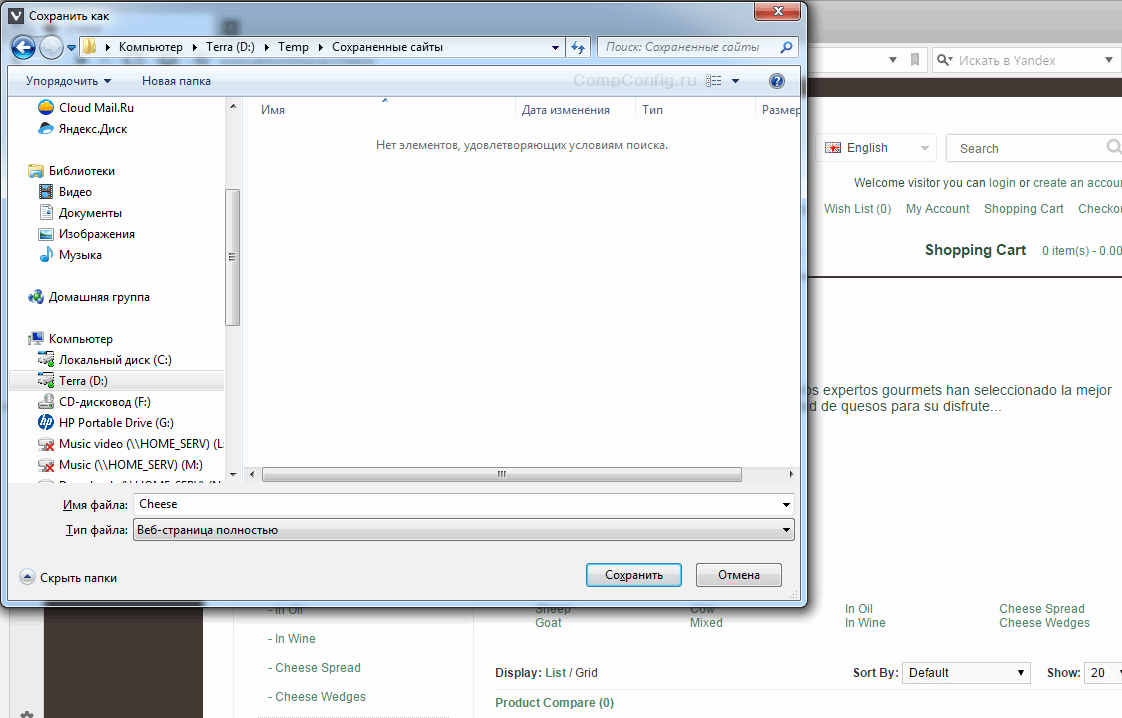

Способ 1. Постраничное сохранение

Самый простой способ о котором все знают, даже если ни разу не пользовались. Эта возможность есть в любом браузере. Достаточно лишь нажать комбинацию клавиш «Ctrl»+«S», после чего в открывшемся окне отредактировать название сохраняемой страницы и указать папку, в которую ее следует поместить.

Хорошо, если сайт маленький, или состоит всего из одной страницы, а если нет? Придется выполнять это действие для каждый из них. В общем, работа для усидчивых и целеустремленных, не знающих об одном из основных двигателей прогресса.

Способ 2. Использование онлайн-сервисов

Вот оно, самое простое решение. Сейчас много есть полезных онлайн-ресурсов для перекодирования файлов, редактирования аудиофайлов и т. п. Среди достоинств этого метода – кроссплатформенность, отсутствие необходимости захламлять свою операционную систему утилитами, которые, возможно, понадобятся лишь однажды.

Всего делов-то, зайти на такой ресурс, ввести в строку адрес интересующего сайта, нажать кнопку запуска процесса скачивания и подставить «емкость», в которую польется интересующая информация…

В теории так, но, к сожалению, подобных онлайн-ресурсов, позволяющих скачать сайт целиком, раз, два, три и… И, пожалуй, все, если говорить о бесплатной возможности сохранить копию сайта на компьютер. А за все остальное придется платить, или мириться с урезанным функционалом.

Но давайте рассмотрим примеры поближе.

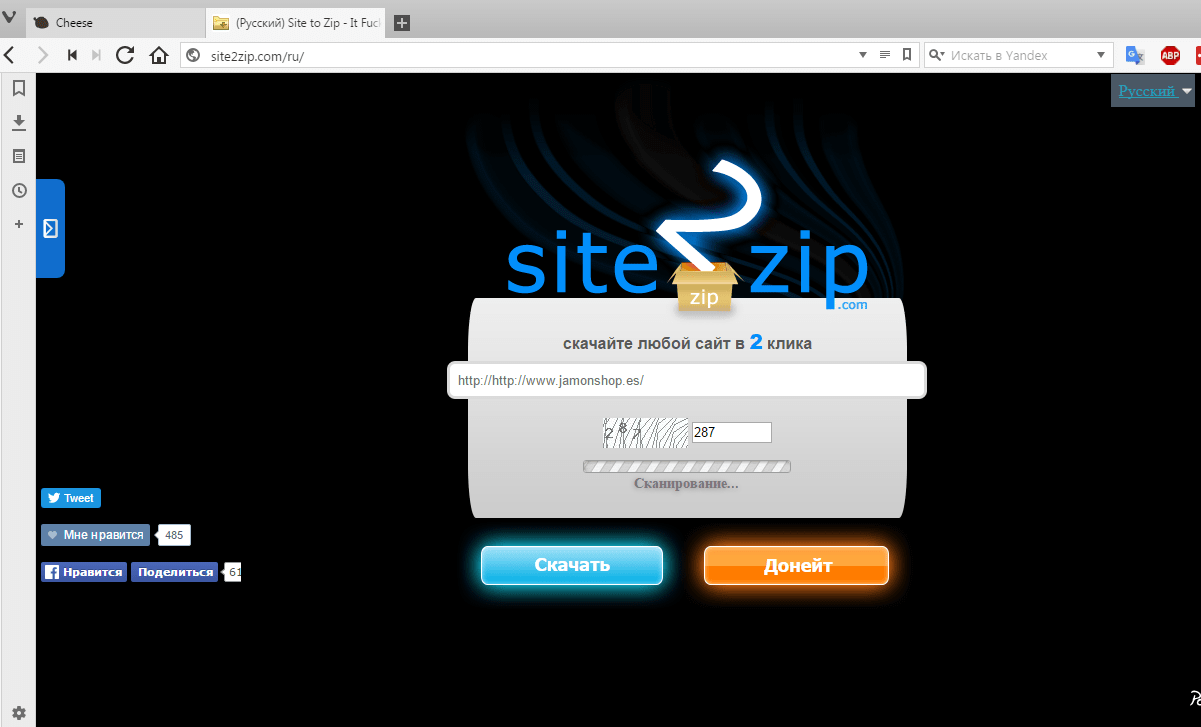

Site2Zip.com

Перестал работать в начале 2019 года.

Едва ли не единственный бесплатный и русскоязычный ресурс. Интерфейс предельно прост. В строке вводим адрес интересующего сайта, вводим капчу, нажимаем кнопку «Скачать» и ждем…

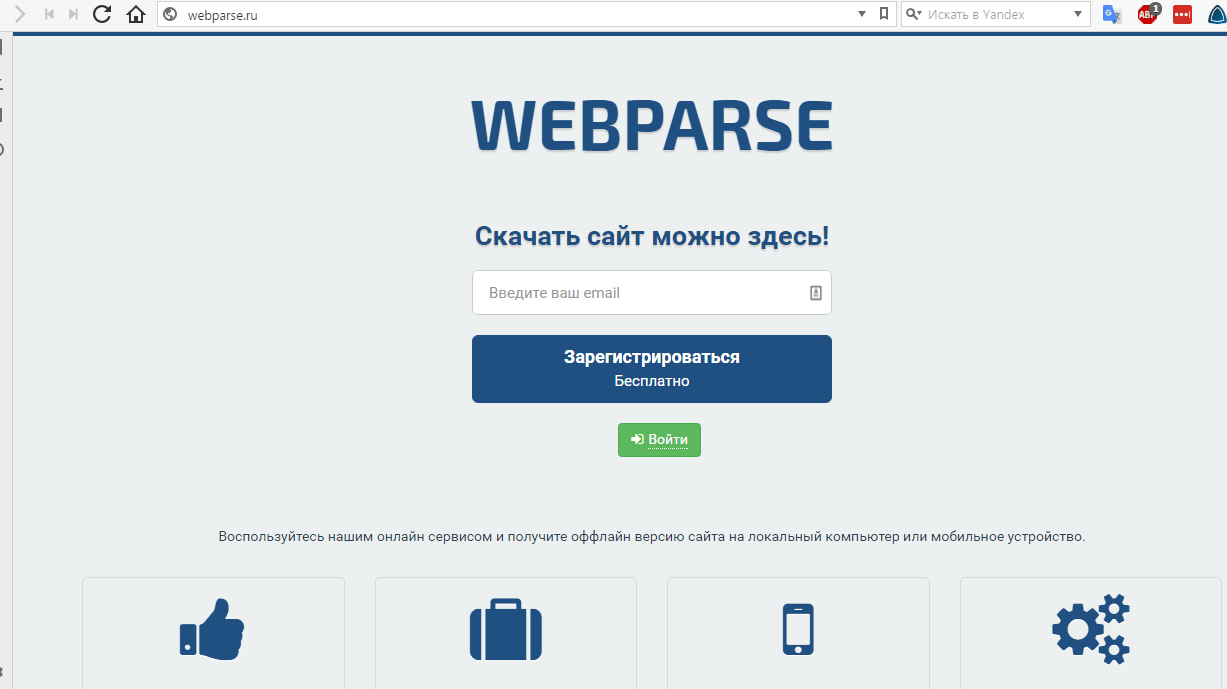

Webparse.ru

Условно-бесплатный ресурс, позволяющий один раз воспользоваться его услугами бесплатно, после чего за скачивание сайтов придется платить.

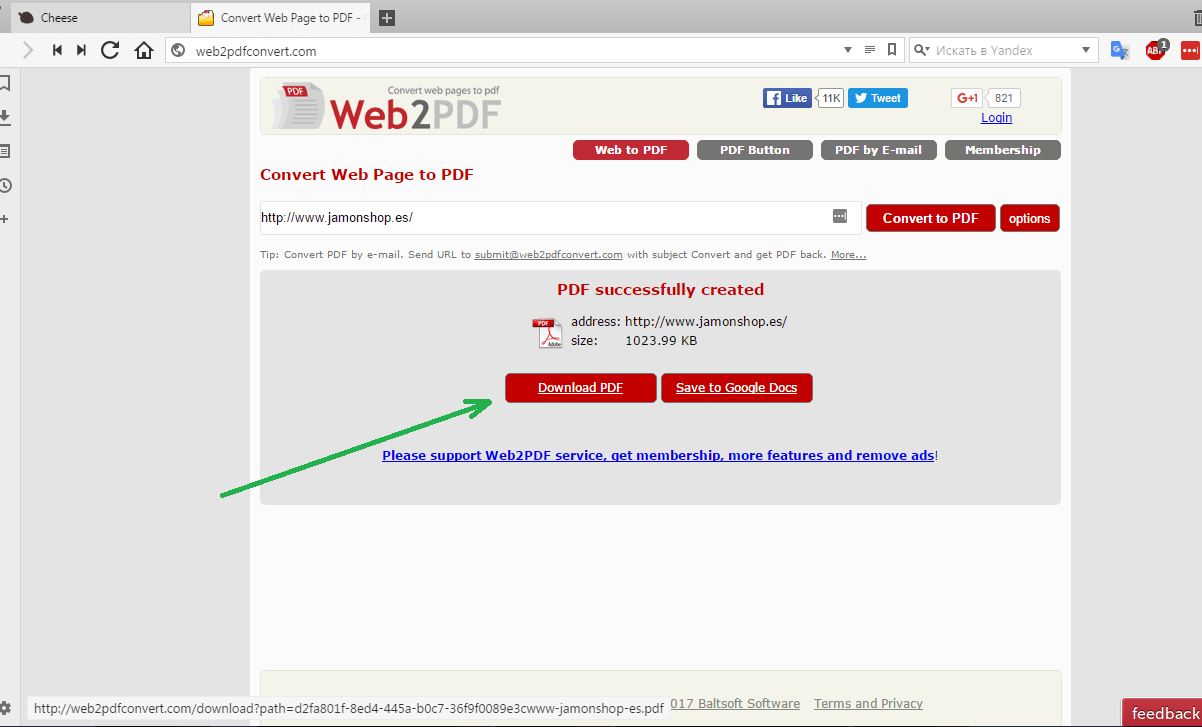

Другие ресурсы

Среди других способов можно отметить ресурс Web2PDFConvert.com, создающий PDF-файл со страницами скачиваемого сайта. Естественно, часть функционала сайта будет утеряна. Если это допустимо, то воспользоваться данным ресурсом можно.

Способ 3. Специализированные программы

Использование утилит для скачивания файлов — пожалуй, наиболее функциональный вариант, позволяющий добиться своей цели. Придется смириться с тем, что в системе появятся дополнительные программы, одна часть из которых бесплатна, а другая – более меркантильна и требует за выполнение тех же функций поощрение. Причем, бесплатные программы (иногда их еще называют оффлайн-браузерами) по возможностям практически не уступают платным аналогам.

В отличие от онлайн-сервисов, подобная программа работает гораздо быстрее, хотя придется искать подходящую под вашу ОС версию этого ПО. Некоторые программы можно найти не только для ОС Windows, но и для других.

Рассмотрим несколько примеров таких программ.

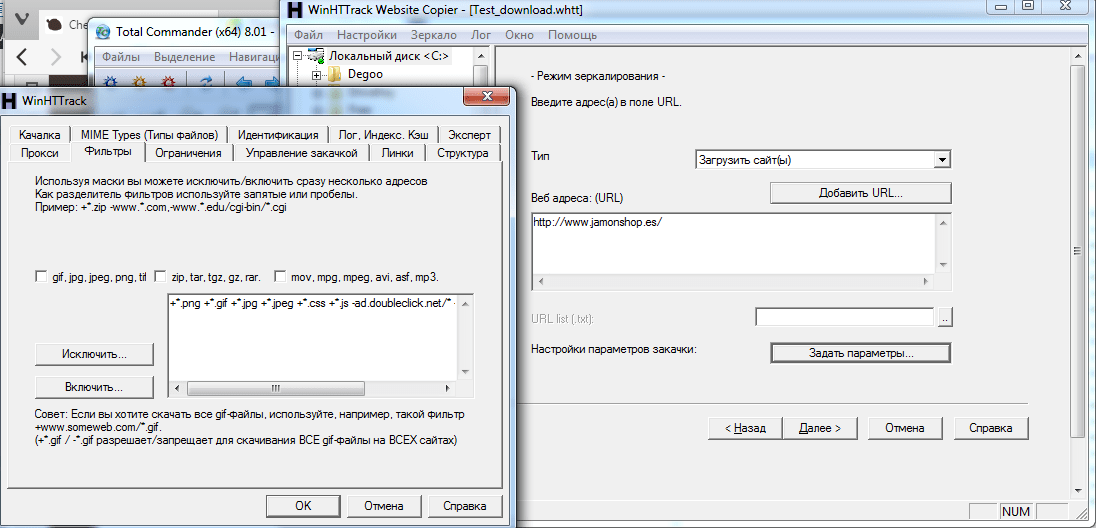

WinHTTrack WebSite Copier

Одна из самых популярных программ, предназначенных для создания оффлайн-копий сайтов. Справедливости ради надо сказать, что бесплатных аналогов практически нет.

Для того, чтобы пользоваться программой, надо скачать с сайта разработчика подходящую версию, проинсталлировать ее в свою систему и запустить. В первом окне будет предложено выбрать язык интерфейса. Среди всех вариантов есть и русский.

Интерфейс программы прост и запутаться в нем не получится. В первом окне надо указать имя и категорию проекта, а также указать место, где будет храниться скачиваемый сайт.

Теперь папку с проектом можно скачивать на любой носитель и просматривать там, где это удобно.

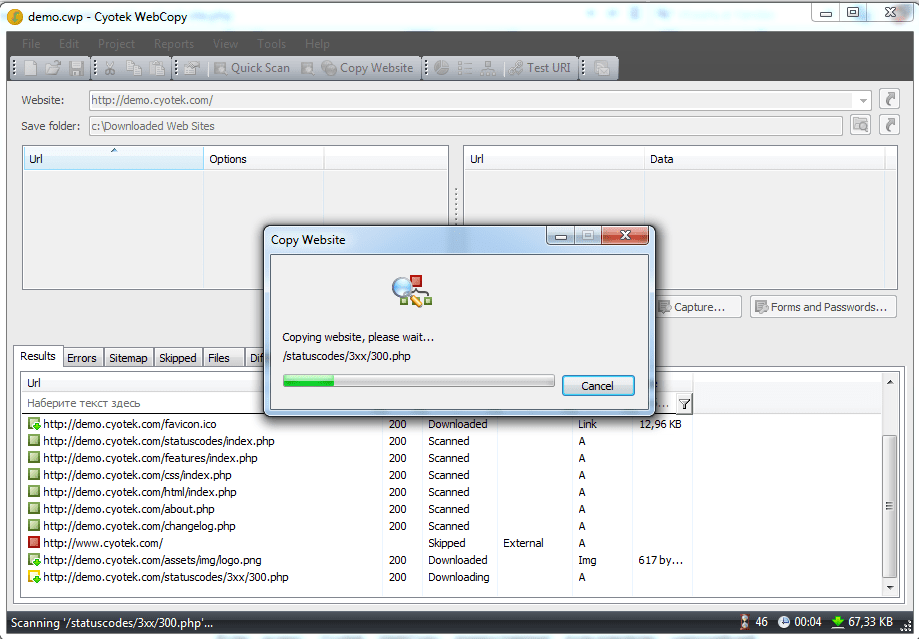

Cyotek WebCopy

Англоязычная программа с солидно выглядящим интерфейсом и большими возможностями по настройке процедуры скачивания сайта. Достаточно только вести адрес интересующего ресурса, указать папку, в которую сохранить скачанные данные и нажать кнопку «Copy Website».

Из недостатков можно отметить только отсутствие русификации, а также то, что Cyotek WebCopy работает только на ОС Windows, начиная с версии Vista. Версий под другие ОС нет.

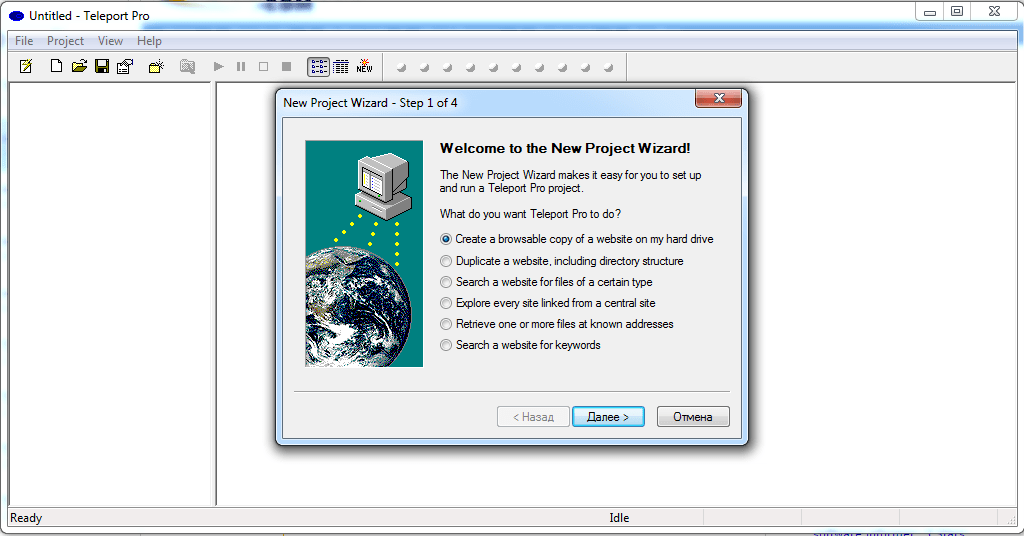

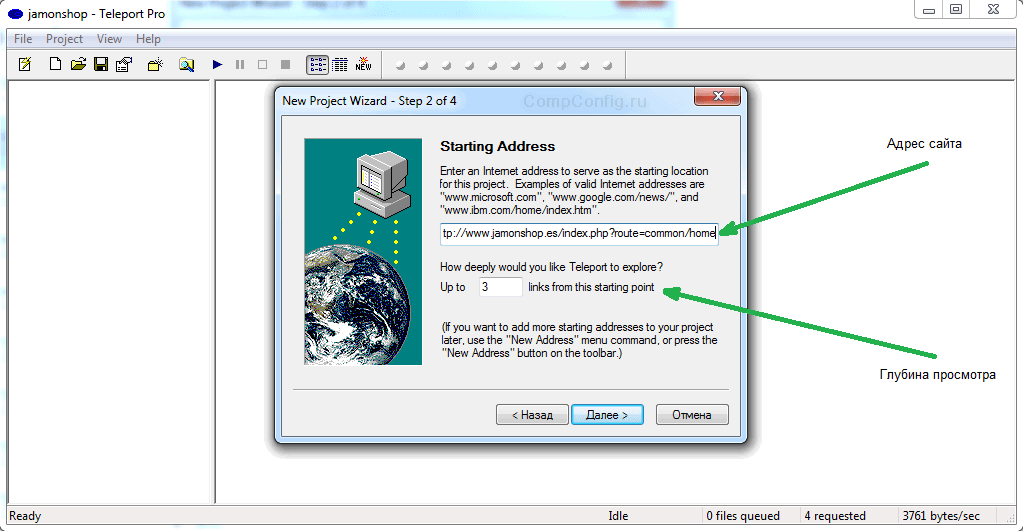

Teleport Pro

Одна из старейших программ, к сожалению, платная. Имеется тестовый период. После установки и запуска появится главное окно, где необходимо указать режим скачивания сайта. Это может быть полная копия, можно сохранить только определенный тип файлов и т. п.

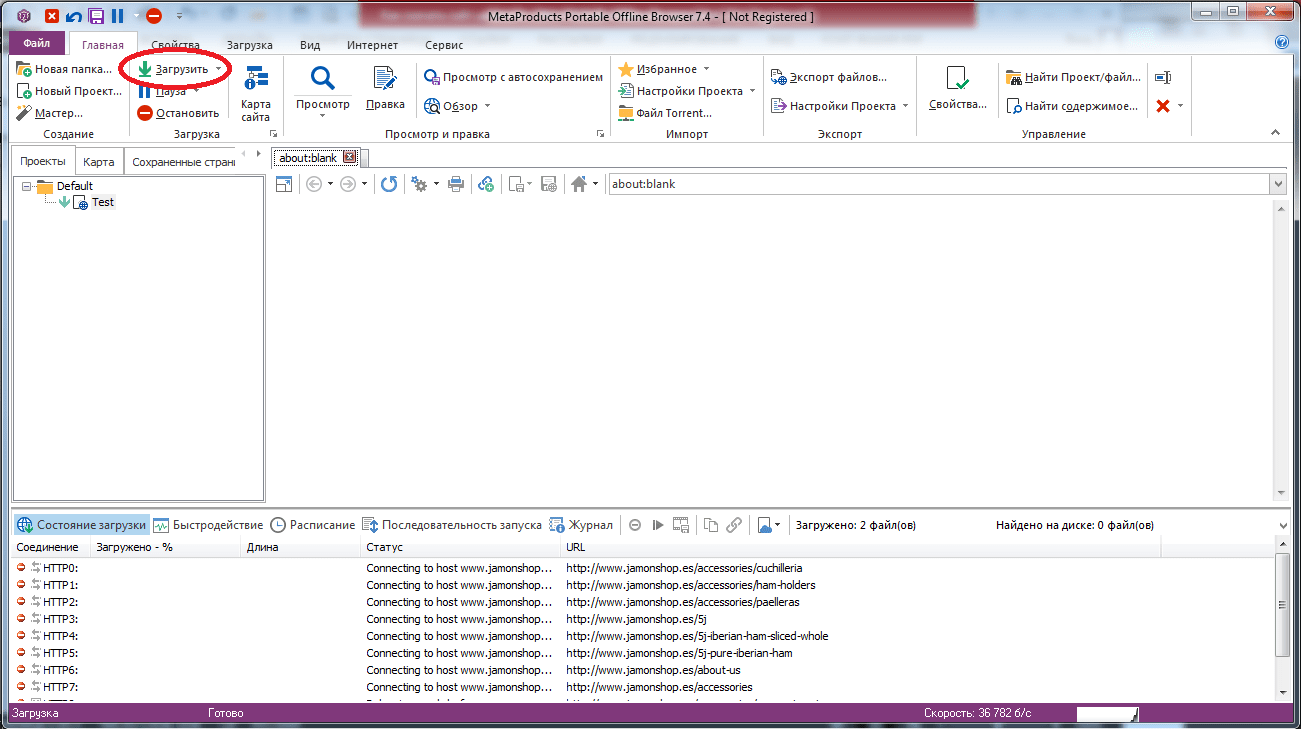

Offline Explorer

Еще одна платная, но весьма функциональная программа. Есть русифицированная версия. Триальная версия работает 30 дней, при этом есть ограничение на количество скачиваемых файлов – 2000. Программа существует разновидностях Standard, Pro и Enterprise. Самая дешевая версия стоит 59.95$, а самая дорогая – 599.95$.

Как и в других программах, работа начинается с того, что необходимо создать новый проект и указать адрес интересующего сайта. Доступно большое количеств настроек, при помощи которых можно отфильтровать ненужную информацию, задать глубину просмотра сайта и т. п.

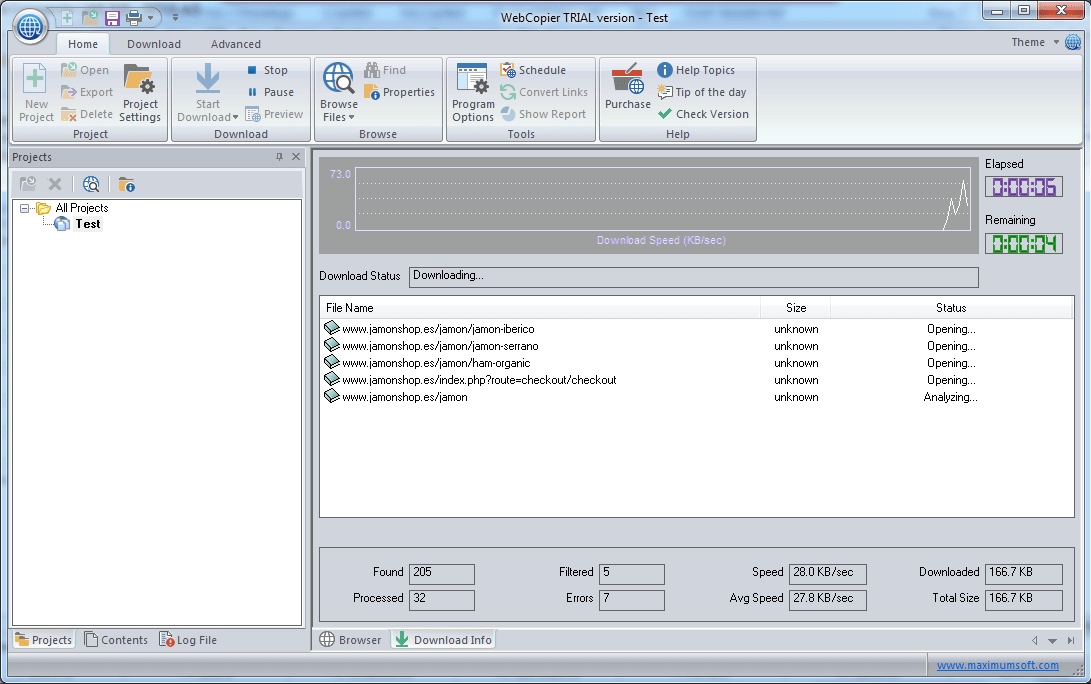

Webcopier

Платная программа с 15-дневным триальным периодом. Существует в версиях для Windows и Mac OS. Алгоритм работы не отличается оригинальностью, что, впрочем, является плюсом. Для скачивания сайта надо создать новый проект, ввести URL.

Заключение

Возможностей создать локальную коллекцию нужных сайтов для их просмотра достаточно. Есть и онлайн-ресурсы, есть и специализированное ПО. Каждый из вариантов имеет свои достоинства и недостатки. К сожалению, большинство программ платные, и готовы ли вы раскошелиться за более широкий функционал или достаточно того, что умеют бесплатные утилиты – решать каждому самостоятельно.

Прежде чем отдавать предпочтение тому или иному решению, следует попробовать их все, благо даже платные программы имеют тестовый период, пусть и с некоторыми ограничениями. Это позволит оценить возможности этого ПО, понять, необходим ли вам весь этот функционал, насколько корректно производится скачивание сайтов.

Очень часто возникает необходимость в копировании стороннего сайта. В то время, как копирование с помощью встроенной функции браузера «сохранить как», не работает должным образом, можно воспользоваться программой wget.

В этой статье будут рассмотрены основные команды wget, на примере будет показано, как скачать страницу с помощью wget для локального просмотра, а так же, как скачать https сайт.

- Скачивание страниц по списку из файла

- Как задать папку для скачивания

- Рекурсивное скачивание подкаталогов

- Выкачивание всего сайта

- Скачивание страницы с локальным сохранением клиентских файлов

- Скачивание http-страниц

- Резюме

В этой статье я не буду рассматривать установку wget на компьютер. Я воспользуюсь сборкой Open Server, в которой эта программа уже включена. Open Server — это сборка локального веб-сервера. Потому, если вы не программируете на php, то смысла устанавливать Open Server не много. Для вас лучший вариант — это отдельная установка wget.

Wget — это консольная программа для загрузки файлов. Это программа чем-то похожа на CURL, однако, они решают совсем разные задачи. Wget позволяет скачивать страницы сайта, вместе с полным содержанием страницы (css, js, картинки) к себе на компьютер. Что позволяет открыть этот сайт у себя, без интернета, абсолютно не искажая его исходное отображение. Так же, эта программа включает в себе возможность рекурсивного скачивания страниц, что позволит с помощью wget скачать весь сайт целиком, и отображать его локально.

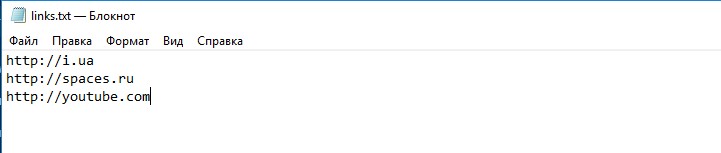

Скачивание всех страниц по списку из файла

wget -i YOURFILE, где YOURFILE — путь к файлу, с URL-адресами

Например, у меня есть файл links.txt:

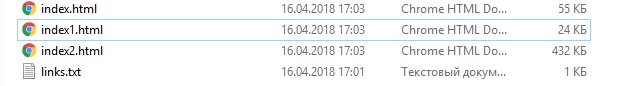

Теперь, запустив команду wget -i links.txt (у меня links.txt находится в той папке, относительно которой запущена консоль)

И в результате получим 3 файла, как и было в списке:

Скачивание в указанную папку

Для того, чтобы скачать в нужную нам папку, нужно выполнить:

wget -P /path http://example.com, где /path — папка для сохранения, http://example.com — url-сайта, который нужно скачать

-P — путь сохранения (указывается -P /path)

Например, скачаем содержимое главной страницы http://badcode.ru в папку files

Выполним:

wget -P files http://badcode.ru

И wget создаст папку с названием files, и куда сохранит содержимое нашего сайта

Рекурсивное скачивание каталога и вложенных подкаталогов

wget -r --no-parent http://example.com/catalog

Проверим это на примере скачивания всех статей одного из тегов: http://badcode.ru/tag/parsery/

Выполнив:

wget -r --no-parent http://badcode.ru/tag/parsery/

Скачивание всего сайта

wget -r -l 5 -k -p http://example.com

Каждая из опций значит:

-r — рекурсивно открывает новые найденные страницы

-l — глубина рекурсии -l 5, что значит, что максимально рекурсивно будет открыто 5 ссылок

-k — конвертирование ссылок на локальные, загружая файлы (css, js, картинки) к себе в папку

-p — скачать в папку все нужные файлы для отображения страницы без интернета

Выполнив:

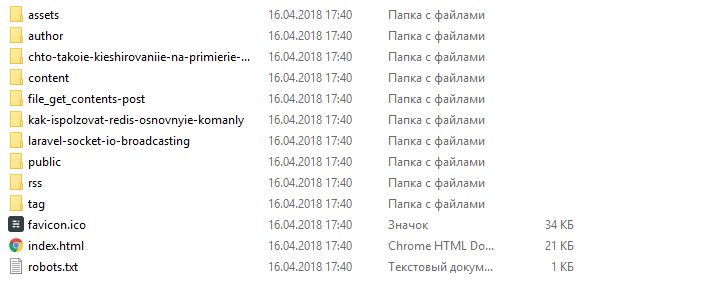

wget -r -l 5 -k -p http://badcode.ru

Получим результат в виде всех скачанных статей, которые без проблем можно читать без интернета:

Скачивание одной страницы со всеми файлами

Эта команда будет симбиозом того, что мы уже рассмотрели.

wget -k -p http://example.com

А ключи -k и -p нам уже известны: это значит, что мы говорим wget скачать все файлы, и проставить пути так, чтобы можно было открыть эти страницы локально, без интернета.

Скачивание https-страницы

Для того, чтобы скачать https-страницы, просто нужно добавить опцию --no-check-certificate

На прошлом примере, что будет иметь вид:

wget -k -p https://example.com --no-check-certificate

Резюме

Цель этой статьи — показать, с какой простотой и удобством можно пользоваться Wget. Я постарался ответить на то, как сохранять страницы, или даже целые сайты к себе локально, и просматривать их без интернета. В этой статье были описаны основные команды Wget, если вы хотите более продвинутого пользования этим инструментом, то этой информации будет недостаточно.

Ранее, для того, чтобы скопировать какую-то страницу, я прибегал к использованию сторонних сервисов, которые, зачастую, являются обёрткой над Wget. Потому, изучив основные команды Wget, необходимость в других сервисах отпадает сама собой.

К слову, моя «история фриланса», как раз и началась, с того, что я копировал лендинги, и тут мне очень помогали знания, связанные с Wget.

Содержание

- Скачать сайт целиком – зачем это нужно?

- Скачать сайт целиком и переделать?

- 7 способов бесплатно скачать сайт

- Web2zip

- Saveweb2zip

- CopySite

- Web ScrapBook

- Httrack

- Cyotek WebCopy

- Wget

- Советы и выводы

Нередко возникает необходимость скачать сайт целиком, чтобы можно было просматривать его в режиме offline. Например, если на сайте много текстовой информации, проще скачать его полностью, чем создавать скриншот каждой отдельной страницы. Это может быть полезно, если необходимо скачать документацию, содержащую 500-1000 веб-страниц.

Также необходимость скачать сайт целиком возникает у программистов, а именно у тех, кто занимается frontend-разработкой. Благодаря этому специалисту не нужно каждый раз заходить на сайт, чтобы увидеть, как именно сверстаны его страницы. Он может скачать сайт и просматривать его в режиме offline.

Скачать сайт целиком и переделать?

Стоит понимать, что, копируя сайт, вы с большой вероятностью столкнетесь с “сюрпризами”, которые обязательно нужно проверить перед работой:

- корректная верстка (все элементы на своих местах, работает исправно и мобильная версия, и десктоп),

- все картинки загружаются (при копировании, возможно, что-то не сохранилось, неправильно указан путь файла в коде),

- активные элементы работают исправно (кнопки, формы).

Все эти мелочи исправляются за несколько минут самостоятельно, либо с помощью фрилансеров, если речь идет о скриптах.

Для самостоятельной работы с кодом рекомендуем: Sublime Text, Visual Studio Code, Atom.

Далее, все что вам останется – перенести сайт на ваш хостинг с доменом.

Так чем же скопировать сайт?

Самый простой способ: “Ctrl+S” – команда в браузере, которая сохраняет текущую страницу. Быстро, без посторонних сервисов, но с высокой вероятностью потерять часть сайта (динамические элементы, скрипт, формы) – больше подойдет для копирования контента страниц.

Если вам нужно скопировать работоспособный одностраничный сайт, то лучше обратиться к специальным сервисам, которые помимо HTML, копируют CSS, JavaScript, все изображения, анимации, ссылки и формы. Тем более, что часть из них полностью бесплатна.

Web2zip

https://web2zip.ru/ – бесплатный онлайн сервис с простым интерфейсом. Вводим нужный нам url сайта, нажимаем скопировать и получаем сайт в архиве с возможностью предпросмотра онлайн.

Сервис копирует HTML, CSS, JavaScript, изображения и шрифты.

Приходилось ли Вам скачивать сайты?

ДаНет

Saveweb2zip

https://saveweb2zip.com/ru – онлайн-сервис с бесплатной возможностью скачать сайт, сохраняя HTML, CSS, JavaScript, изображения и шрифты. За дополнительную плату можно заказать настройку форм и решение других вопросов.

При скачивании есть возможность автоматически переименовать названия файлов, скопировать мобильную версию сайта.

CopySite

https://copysite.link/ – онлайн-сервис уже с платной подпиской, но более широким функционалом. При скачивании есть возможность использовать прокси, заменять слова, ссылки, автоматически удалять теги, счетчики метрик и форматировать код.

Web ScrapBook

Web ScrapBook – бесплатное браузерное расширение, которое позволяет скачивать необходимые страницы сайта не покидая целевую страницу.

Сервис имеет широкий опционал для настройки, позволяющий работать с мультимедийными файлами и скриптами: скачивать, вырезать, заменять, пропускать.

Httrack

Httrack – бесплатный локальный сервис, для работы нужно устанавливать на компьютер. С задачей справляется отлично, основное преимущество – можно скачивать несколько сайтов одновременно (списком загружать url), всегда готов к работе (не зависит от работоспособности онлайн-сервисов), менее удобен, чем решения выше.

Cyotek WebCopy

Cyotek WebCopy – один из сервисов компании Cyotek, требует установки, но абсолютно бесплатный. Копирует контент, а также стили, но теряет JavaScript.

Отлично подойдет для парсинга контента сайтов и копировании простых сайтов.

Wget

wget – консольная утилита, которая позволяет копировать сайты без графического интерфейса, используя команду типа “wget -r -k -l 7 -p -E -nc http:/vash.site/”

Параметры отвечают за:

- -r — указывает на то, что нужно переходить по ссылкам на сайте, чтобы скачивать все подкаталоги и все файлы в подкаталогах.

- -k — преобразует все ссылки в скаченных файлах, чтобы по ним можно было переходить на локальном компьютере в автономном режиме.

- -p — указывает на то, что нужно загрузить все файлы, которые требуются для отображения страниц (изображения, css и т.д.).

- -l — определяет максимальную глубину вложенности страниц, которые нужно скачать. Обычно сайты имеют страницы с большой степенью вложенности и чтобы wget не начал «закапываться», скачивая страницы, можно использовать этот параметр.

- -E — добавлять к загруженным файлам расширение .html.

- -nc — указывает на то, что существующие файлы не будут перезаписаны – например, при продолжении ранее прерванной загрузки сайта.

Среди платных решений стоит выделить также: RoboTools (2$ – 250 стр), Teleport Pro ($50).

Скопировать любой сайт в 2021 году может абсолютно каждый пользователь, который даже не знает про программирование, код и прочее – для этого есть широкий выбор сервисов. Они отлично решают вопрос скачивания одностраничных лендингов, сохраняя их работоспособность, но далеко не всегда могут справиться с сложными сайтами.

Если вам нужен качественный сайт или его копия, то рекомендуем все же обратиться к специалистам – тогда значительно повысится вероятность, что все элементы будут корректно работать, сайт – выполнять свою задачу, а трафик – приносить вам деньги.

Существует сразу несколько способов, с помощью которых можно скачать сайт целиком. Если сайт небольшой (состоящий из 1-5 веб-страниц), то можно обойтись и простым постраничным скачиванием, которое работает в каждом браузере. Для этого достаточно использовать комбинацию клавиш «Ctrl» + «S» и выбрать место, куда загрузится сайт.

Если же ваша деятельность требует регулярного скачивания многостраничных сайтов, то проще один раз установить специализированную утилиту. Во многих случаях можно обойтись и бесплатными версиями программ, так как в их функционале присутствует все необходимое. Если же вас интересуют дополнительные инструменты, придется раскошелиться на платную версию. Но не стоит надеятся на то, что все скаченные сайты можно запустить в офлайне, программы хорошо подходят для скачки сайтов на не сложных движках.

Чтобы не было сюрпризов, обязательно проверяйте работоспособность сайта перед работой со всех устройств!

“Новое — это хорошо забытое старое…”. Кажется, в мире интернета смысл этой поговорки немного изменился. В условиях миллиардной аудитории никто не ждет, пока какой-то проект или красивый лендинг забылся. Копирование, копирование и еще раз копирование — это философия не только небольших частных предпринимателей, которые просматривают сайт-визитку или витрину магазина где-то за океаном. Копируются соцсети, мессенджеры, маркетплейсы, различные сервисы для бизнеса. И плагиат распространен в мире арбитража трафика.

Увидели красивый лендинг или крутой преленд с высокой конверсией? Необязательно тратить много времени и делать все с нуля. Если не копировать, то какой смысл в SPY-инструментах. Но простое использование команд “Ctrl+C” и “Ctrl+V” не работает. Да и при копировании страницы теряется код, нарушается верстка, пропадают картинки, отсутствует анимация. Не работают формы обратной связи, партнерские ссылки для переадресации на сайт рекламодателя засчитываются владельцу донора.

Можно ли скопировать сайт так, чтобы его можно было отредактировать под себя и залить на сервер? И как это сделать? Об этом сегодня и поговорим. Усаживайтесь поудобнее, впереди вас ожидает только полезная информация и рабочие советы.

Можно ли скопировать любой сайт

Если коротко — не все так однозначно… Из теории мы знаем, что при переходе на какой-то сайт, браузер подает запрос, сервер ему отвечает и передает данные в виде html-кода. Это язык разметки, после загрузки данных в окне web-браузера мы видим содержимое сайта. При этом локальная копия исходного кода хранится в буфере. Кеш временно сохраняться на жестком диске в папке C:UsersUSERNAMEAppDataLocalGoogleChrome. Достаточно извлечь из памяти данные страницы и сохранить. Но, было бы все так просто, каждый арбитражник да каждый школьник уже создал бы собственный *Facebook, Youtube, TikTok или криптобиржу.

Но современный сайт — это больше, чем веб-документ в формате html. Масштабные проекты да и простые лендинги чаще пишутся с использованием языка PHP или создаются на базе систем управления контентом (CMS), таких как WordPress, Joomla, MODx, Drupal. Собранные в визуальном конструкторе за 10 минут блоги и лендинги на их основе также в своей основе имеют код php. Структура таких порталов, даже небольших, двухуровневая: frontend — то, с чем взаимодействуют пользователи (именно взаимодействуют, а не просто просматривают), и backend — часть, исполняемая на сервере.

❗❗❗Интересно знать — 📢Как правильно сделать лендинг пейдж самому: пошаговая инструкция.

Современный сайт может быть полностью построен на базе динамических скриптов (например, адаптивные лендинги, которые подстраиваются под размер экрана) или содержать отдельные элементы. Это может быть “калькулятор” для расчета заказа, форма обратной связи, курсы валют или другие данные, которые могут меняться.

Можно скопировать только те скрипты, которые исполняются на стороне посетителя. Серверная часть для скачивания не доступна. Но исходный код и ответ сервера, который видят пользователь — это не одно и то же. При каждом обращении данные могут отличаться. Вы можете сохранить себе на компьютер код, выданные сервером. Но в дальнейшем такой проект без существенной доработки бек-энда работать не будет. После загрузки на сервер максимум, что можно получить — статический сайт с множеством проблем:

- сбивается верстка на адаптивных сайтах: съезжают кнопки, таблицы, текст;

- часть информации, как текстового, так и графического контента, становится недоступной;

- не работают формы, в некоторых случаях при заполнении полей обратной связи заявки будет получать конкурент, у которого вы “своровали” сайт;

- ни о какой адаптивности говорить не стоит: сайт будет всегда адаптированным под размер экрана устройства, с которого было копировано.

Хорошая новость в том, что простые сайты скопировать можно и даже обеспечить их корректную работу после минимальных правок в визуальном редакторе и ввода штучных изменений в код. Это лендинги, прелендинги, сайты-визитки и даже небольшие интернет-магазины на несколько страниц.

Загрузить можно даже сайт, который работает с использованием динамических таблиц. Правда мы получим статическую страницу с урезанными функциями (например, без адаптации под размер экрана).

А зачем вообще копировать чужой сайт

Если перефразировать слова Остина Клеона из книги “Кради как художник”, копирование — это творческий процесс, если мы, конечно, просто не выдаем чужие наработки за свои. И он ведет нас к прогрессу. Используя готовые образцы за основу, мы создаем что-то новое. Становится актуальным вопрос: что хорошо, а что плохо? “Существует только то, что достойно или недостойно быть позаимствованным…”.

Копирование помогает переосмыслить чужие идеи и сделать что-то лучшее. Для веб-программистов и верстальщиков — это возможность разобрать чужой код, изучить особенности работы скриптов, анимацию, чтобы потом использовать эти идеи в новых проектах.

Актуально копирование сайтов в арбитраже трафика и среди маркетологов, которые запускают рекламные кампании в сети. Можно потратить месяцы и тысячи долларов (это при самых скромных подсчетах) на тестирование лендингов и прелендингов, сайтов визиток и одностраничных магазинов (неважно, созданным с нуля или на базе шаблонов). Но все равно не получить результат.

Альтернатива — найти Landing Page через SPY-инструмент, посмотреть статистику, выбрать и, естественно, доработать под себя. Второй способ занимает немного времени, буквально часы. И бонус — можно сразу скопировать рабочую связку типа “баннер+лендинг”, “прелендинг+лендинг” или даже “баннер+преленд+лендинг пейдж”.

❗❗❗Читайте также: Как припарковать домен — подробный гайд.

Последствия копирования чужих сайтов

Прежде чем переходить непосредственно к основному разделу с советами, вспомним о последствиях, которые могут ожидать при копировании:

- административная ответственность. За копирование чужого сайта (прежде всего это касается дизайна и логотипов) на вас могут подать в суд. Но это возможно только в случаях, когда скопирован уникальный портал, например интернет-магазин, который разрабатывался с нуля, а не лендинг по бесплатному шаблону;

- владелец оригинала через суд может заставить вас удалить свой ресурс, если вы копируете магазин или страницу захвата. Вы потеряете клиентов, которых успели привлечь, усилия на доработку и продвижение пропадут зря;

- вы теряете часть клиентов, когда используете чужой дизайн: клиенты будут ассоциировать вас с компанией-донором сайта, в следующий раз могут обратиться в другую компанию;

- возможна просадка конверсии — в случае, если лендинг уже надоел аудитории, пользователи будут его игнорировать, так как часть целевой аудитории уже отклонила предложение или воспользовалась им.

Все же в арбитраже, если успеть вовремя заметить лендинги и прелендинги с высокой конверсией, копирование сайта позволяет быстро запустить рабочий креатив и увеличить ROI, сберегая время и силы на разработку. А web-программисты получают образец для тренировок и разбора удачных решений.

Как скачать веб сайт на компьютер через браузер

Самый очевидный способ скопировать web-сайт — скачать его с помощью браузера. При этом доступно сразу два способа:

- народный Ctrl+S (“Страница” — “Сохранить как…” в Opera. В Chrome опция запрятана в “Дополнительных инструментах”) — метод, который сразу приходит на ум;

- копирование кода страницы через “Инструменты разработчика” в меню “Разработка” (в браузерах на базе Google Chrome — в меню “Дополнительные инструменты”).

Кажется, все просто, зачем еще заморачиваться. Используем команду “Ctrl+S” и получаем готовый html-файл. Не все так, как кажется. Функция сохранения создана, в первую очередь, чтобы можно было просматривать информацию автономно, когда нет доступа к интернету. И это не самый удобный способ копирования сайта.

Доступно три варианта скачивания:

- только html;

- одним файлом;

- страница полностью.

Первый метод предполагает сохранение только html-разметки. Если такую страницу просматривать без интернета или попытаться установить на сервер, то мы увидим только таблицы, заголовки. Большая часть контента, картинки, формы, виджеты и даже часть текста, будет утеряна.

Очевидно, нужно выбрать пункт “Страница полностью” или “Одним файлом”. В первом случае будет сохранен html-файл вместе с папкой, в которой сохраняются файлы стилей, шрифты, картинки, ссылки на другие страницы. Во втором создается веб-архив: HTML документ вместе с javascript, css, аудио и видео, закодированный по методу MIME (.mhtml) — по такому же принципу кодируются сообщения электронной почты.

И mhtml-архив и html-докумет с файлами позволяют просматривать содержимое страницы в автономном режиме. Но в случае загрузки на сервер сайт работать не будет или с заметными искажениями, хотя сохраненные страницы можно открыть через визуальный редактор (и даже через текстовый редактор типа MS Word), отредактировать и уже сохранить в правильном формате.

Но главный недостаток — за один раз вы сохраняете только одну страницу. Если это большой сайт, на выходе получится много папок, не связанных между собой, которые придется связывать вручную.

Более продвинутый способ копирования — через инструменты разработчика. Позволяет скопировать не только саму html-разметку, но и структуру файлов сайта с каталогами.

Чтобы скопировать сайт:

- входим в меню “Разработка”;

- выбираем “Инструменты разработчика” (Ctrl+I или Ctrl+Shift+I) — перед нами появляются DevTools;

- выбираем вкладку “Sources” — в левой части окна открывается окно с деревом каталогов;

- просматриваем структуру страницы — обычно файлы сайта идут в первой папке, ниже — папки с внешними скриптами (обычно, их копировать не нужно);

- создаем на локальном хранилище (жесткий диск, флешка, облачное хранилище, куда мы будем копировать страницу) папку с названием страницы, внутри создаем каталоги в соответствии со структурой зеркала сайта;

- сохраняем поочередно все файлы, кликнув по ним правой кнопкой мыши и выбрав команду “Save As”. К сожалению, скопировать все файлы одним махом или папку целиком возможности нет;

- копируем название файлов (символы в названии после вопросительного знака (“?”) копировать необязательно), если оно не подставилось автоматически;

- если нужно скачать изображение, то мы кликаем по нему в каталоге в левой части окна, после этого нажимаем по самому объекту правой кнопкой мышки и выбираем все ту же команду — “Save As”.

Повторяем процедуру для всех страниц сайта. Естественно, если названия папок с контентом совпадают, то на сервере используется общий каталог, создавать новый на локальном диске не нужно.

Если инструментов разработчика нет, можно пойти по более длинному пути. Создаем папку с названием сайта, внутри три каталога: img — для изображений, видео; css — для файлов стилей; js — для файлов скриптов. Открываем главную страницу копируемого сайта. Нажимаем “Ctrl+U” — браузер откроет исходный код страницы. Копируем его и вставляем в блокнот. Сохраняем файл в папке сайта (корневой папке) под именем index.html. В исходном коде находим ссылки на скрипты, изображения (заканчиваются расширением .jpg, .png), стили (css), скрипты (js) — кликаем по ним. Код сохраняем с использованием блокнота. Помещаем в папки с соответствующим названием. По такой же схеме сохраняем все страницы.

Правда смысла в этом методе немного. В современных браузерах, даже небольших авторских проектах, реализованы инструменты разработчика. Да и удобнее пользоваться парсерами, способными в автоматическом режиме просканировать все страницы и скачать сайт целиком.

Специализированные программы для копирования сайта — парсеры

Парсеры, они же грабберы или рипперы — это специализированные программы, которые постранично сканируют сайт или только выбранные разделы, скачивают исходный код и контент, систематизируют данные в автоматическом режиме. У парсеров, как и у обычного браузера, нет доступа к данным, сохраненным на сервере: на это способен лишь хакерский софт, и то только после внедрения шпионского ПО (червя или трояна), которое сольет пароли и логины для доступа или напрямую данные с сервера злоумышленнику. Как вы понимаете, такой софт в свободном доступе не лежит.

Популярная статья: ТОП-6 парсеров Телеграм – где скачать, как пользоваться.

Принцип работы парсеров такой же, как и при постраничном скачивании с помощью команды “Сохранить как…” или через “Инструменты разработчика”. Только поочередно веб-страницы открывает не пользователь, а бот, который имитирует поведение человека. Похожий алгоритм у роботов поисковых систем.

Юзер вводит url-адрес в адресной строке граббера. Приложение подает запрос серверу, тот в ответ выдает html-код. Дальше бот считывает страницу и начинает ее сканирование: ищет все внутренние ссылки и отправляет запрос по ним, потом снова считывает и сохраняет код, стили, скрипты, мультимедиа, контент. Процесс повторяется, пока приложение не сканирует весь сайт.

Парсеры не смогут сделать идентичную копию сайта. Они сохраняют лишь его статический html-слепок (зеркальную копию или дубликат). Но для небольших лендингов часто этого достаточно, где исходный код и страница в браузере — идентичны. И главный бонус — такой софт облегчает работу арбитражников:

- экономит время, десятки часов;

- автоматически систематизирует файлы, создавая структуру сайта, которую можно загрузить на сервер и запустить;

- снижает вероятность механической ошибки, когда какой-то файл сохранен не под правильным именем или помещен не в тот каталог.

Недостаток — по-прежнему невозможно скачать исходный код. Только слепок или зеркальную копию с контентом и ссылками, которую выдает сервер. Остальные минусы зависят от конкретного приложения. Например, некоторое ПО просто скачивает с каждой страницы всю информацию, которую сможет найти. В итоге получается много дублей картинок и скриптов. Сайт размером в 20 мегабайт может разрастись до 200 мб.

В сети выложено много парсеров как бесплатных, так и платных. Есть софт в виде программного обеспечения для установки на локальное устройство (для Windows, Android, MacOS, iOS), скрипты для установки на сервер, онлайн-сервисы.

Специализированные программы для установки на компьютер

WinHTTrack WebSite Copier

WinHTTrack WebSite Copier — приложение для скачивания сайтов, которое распространяется бесплатно. Есть версии для Windows, в том числе устаревших версий Windows 2000, XP (WinHTTrack), Linux, BSD (WebHTTrack). Основная задача — скачивание и упорядочивание файлов. На выходе получаем готовую папку с зеркальной копией сайта, которую можно залить на сервер.

У софта есть много дополнительных опций:

- скачивание закрытых разделов сайта (при наличии доступа — логина и пароля), доступных авторизованным пользователям;

- создание резервных копий в несколько кликов;

- обновление уже скачанного сайта — приложение сопоставит и добавит обновленные разделы или внесет изменения в скачанные страницы;

- возможно одновременное скачивание нескольких сайтов с перекрестными ссылками или скачивание вместе с сайтом страниц других ресурсов, на которые ведут внешние ссылки;

- гибкая настройка формата структуры сохраненного сайта (одним файлом mhtml или сайта полностью), ассоциаций MIME, добавление прокси и др.;

- возобновление прерванных загрузок и другие опции.

Cyotek WebCopy

Еще один бесплатный парсер с широкими возможностями. Софт автоматически упорядочивает структуру, копирует скрытые части сайта, которые доступны только после аутентификации. Полезная функция — захват форм. В отличие от других грабберов, Cyotel WebCopy умеет копировать с сохранением работоспособности формы доступа, обратной связи, заказа, которые реализованы на сервере через динамические скрипты php.

В отличие от HTTrack, есть версия только для Windows, зато здесь более современный и приятный дизайн.

Особенности:

- автоматическое упорядочивание структуры. Парсер сопоставляет все ссылки и переназначает путь к ним после копирования, исключает появление дубликатов;

- можно вручную установить формат, по которому приложение будет упорядочивать структуру;

- доступно сохранение контента в один файл (MIME html);

- опция захвата форм, возможно скачивание закрытых разделов, доступных после авторизации;

- приложение выводит дерево ссылок, в котором можно наглядно посмотреть структуру сайта;

- фильтры, позволяющие сохранить только скрипты или изображения;

- приложение устроено так, чтобы создать зеркальную копию сайта, которая будет работать автономно.

Wget

Это универсальная утилита с множеством полезных функций. Умеет сканировать и копировать сайты по http, https, ftp, ftps. Если оценивать по возможностях — это одно из самых мощных приложений. Умеет сканировать сайт и сохранять исходный код вместе с контентом в один файл (mhtml для локального просмотра), создавать зеркальные копии сайта, которые в дальнейшем можно загрузить на новый сервер. Также среди функций — скачивание исходного кода с сервера по ftp (для разработчиков и владельцев).

Утилита изначально написана для linux, но потом создатели сделали компиляцию для Windows. Но визуальная оболочка отсутствует. Управление граббером через командную строку.

Скачать дистрибутив для Linux можно здесь. Версия для Windows (файл .exe) — здесь.

Процесс установки на Windows:

- загружаем файл или zip-архив;

- извлекаем файл wget.exe, копируем его в папку Windows/System32 (или в другой каталог, который позволяет запускать утилиту через командную строку из любого места);

- запускаем командную строку: прописываем в строке поиска на панели задач cmd (Windows 10, 11) или Win + X — “Выполнить”, пишем команду cmd, нажимаем кнопку ОК;

- вводим команду “wget -h”, чтобы увидеть список команд с расшифровкой;

- для удобства создаем каталог в корневой папке на диске С, куда будут загружаться файлы сайтов (cd / — команда, чтобы переместиться в корневой каталог, md wgetdown — создать папку с названием “wgetdown”).

Некоторые команды:

- сделать зеркало сайта: wget -r https://www.yoursite.com;

- сделать копию сайта и локализовать ссылки: wget —convert-links -r https://www.yoursite.com;

- сделать оффлайн-зеркало с локализацией ссылок: wget —mirror —convert-links —adjust-extension —page-requisites —no-parent https://www.yoursite.com;

- сохранить зеркало сайта как .html: wget —html-extension -r https://www.yoursite.com;

- загрузить изображения: wget -A «*.jpg» -r https://www.yoursite.com.

Web ScrapBook

Браузерное расширение для Chrome, позволяет в несколько кликов скачать копию сайта или отдельную страницу. Также позволяет просматривать на браузере архивированные страницы, когда доступ к интернету отсутствует.

Особенности:

- удобное управление в один клик;

- минимум функций.

Teleport Pro

Одно из самых популярных приложений для копирования сайтов и лендингов среди арбитражников. Приложение может скачать сайт целиком или отдельные страницы со всеми ссылками и адаптацией для просмотра на компьютере. Граббер умеет создавать статические дубликаты лендингов и прелендингов, которые можно запускать на сервере.

Особенности:

- автоматическое восстановление структуры сайта;

- есть возможность настроить адреса ссылок;

- поиск по ключевым словам;

- загрузка скрытых разделов, защищенных паролем;

- создание дубликатов сайта;

- одновременное сканирование нескольких адресов.

Недостаток — устаревший дизайн, немного запутанный интерфейс.

Offline Explorer

Один из самых продвинутых грабберов с большим набором функций, интуитивно понятным и современным интерфейсом. Но он платный. Приложение умеет захватывать сайты целиком или отдельные страницы. С высокой точностью воспроизводит дубликаты страниц в социальных сетях (*Facebook, YouTube, *Instagram), может сканировать защищенные паролем разделы. Разработан на движке Chromium.

Особенности:

- одновременная загрузка нескольких проектов;

- автоматическое скачивание при появлении обновлений (резервное архивирование);

- загрузка по HTTP, FTP;

- реализовано сканирование и копирование страниц в социальных сетях.

Webcopier

Еще один платный проект. Webcopier изначально разработан для корпоративного использования. Это одновременно веб-браузер и инструмент, позволяет в несколько кликов сохранять интернет-каталоги, брошюры, расшаривать данные внутри локальной сети. Для разработчиков реализована возможность поиска мертвых ссылок и анализа структуры сайта.

Маркетологам риппер дает возможность быстро копировать страницы лендингов для дальнейшего редактирования.

Особенности:

- парсер имеет встроенные средства просмотра;

- копирование страниц в несколько кликов;

- сканирование, просмотр структуры;

- загрузка сайта с автоматической корректировкой структуры;

- есть версии для Windows, Mac, Android.

Плагин Save Page WE

Расширение для браузеров Chrome, Firefox. Фактически плагин копирует опцию “Save As…”, но более качественно упорядочивает структуру файлов. И имеет несколько полезных функций, таких как извлечение ссылок и файлов (изображений, видео).

Онлайн-сервисы для копирования сайтов

DollySites

Это не совсем онлайн-сервис, а скрипт, который можно установить на свой сервер (в лицензию входит возможность установки на три IP). Позволяет скачать и отредактировать сайт в несколько кликов, поддерживает прокси и tor-сайты (.union). Есть инструмент захвата и адаптации форм обратной связи. По набору функций DollySite превосходит многие оффлайн-пакеты для локальной установки. После регистрации открывается личный кабинет, где можно управлять загрузками.

Особенности:

- встроенный редактор;

- можно в несколько кликов заменить картинку или текст;

- высокая скорость работы за счет серверных ресурсов;

- можно перевести сайт с помощью встроенного переводчика.

Главный недостаток — скрипт платный. Демо-версия на один час без функции экспорта.

Web2zip

Простой сервис, который позволяет сделать дубликат сайта или лендинга. Функция у приложения только одна — сохранить сайт. Зато инструмент сразу создает zip-архив, готовый к загрузке на сервер и распаковке. Работает без регистрации и авторизации.

Saveweb2zip

Еще один сервис для создания дубликата сайта в один клик с упаковкой в zip. Но у сервиса есть несколько дополнительных функций:

- настройка форм обратной связи, интеграция с партнерками;

- копирование мобильной версии.

Saveweb2zip — один из лучших инструментов арбитражника, который позволяет быстро копировать лендинги и в один клик адаптировать их для захвата клиентов.

RoboTools

Роботулс пошел дальше и предлагает скопировать не только актуальную версию сайта, но и версии за прошлые годы из веб-архивов. Инструмент специально разработан для создания сателлитов. Сервис позволяет скачать сайт за несколько минут. Для загрузки доступен zip-архив, который можно отредактировать или загрузить на сервер и сразу же запустить (после распаковки). Сайт платный — оплата за страницы. Но скачивание с некоторыми ограничениями доступно бесплатно в демо-версии.

Webparse.ru

Сервис для скачивания сайтов в один клик, но с дополнительными функциями: скачивание мобильной версии, сканирование и просмотр контента, загрузка страницы или всего ресурса целиком. Сайт платный, есть пробная версия с одним бесплатным скачиванием.

WebSiteDownloader

Простой инструмент для скачивания сайтов в один клик без регистрации и ограничений. Вставляем ссылку, нажимаем кнопку “Download”. Полезная функция — поддержка скачивания из веб-архива Wayback Machine.

Копирование с использованием услуг фрилансеров и компаний

Еще один способ скопировать сайт — обратиться в веб-студию или к фрилансеру через одну из бирж фриланса. Метод подойдет, если вам понравился лендинг, сайт-визитка или небольшой магазин, сайт с описанием услуг и хочется себе такой же. Это не вариант для арбитражников: от звонка и заключения договора до получения готового сайта уйдет пару дней. Зато вариант для небольших предпринимателей, блогеров, у которых нет возможности и надобности разбираться в тонкостях веб-дизайна, работы с html-разметкой, подключения баз данных и настройки хостингов.

При обращении к фрилансерам, возможны два варианта:

- копирование сайта через парсер с редактированием кода и структуры, изменением контактов, форм обратной связи, некоторых фото. Дизайн будет идентичным, но новые функции добавить практически невозможно. Цена — в пределах 800-1000 рублей. Время работы — 1-2 дня;

- визуальное копирование с помощью конструктора (сборка нового сайта с нуля по шаблону). Этот вариант дороже, в пределах 5000 — 8000 рублей за простой лендинг, сайт на 3-5 страниц. Будут небольшие отличия в дизайне, анимации. Зато можно добавить функции по желанию. Время — до 10 дней.

В любом случае вы получаете сайт с правильной версткой без ошибок, с работающими формами обратной связи.

Студии, где можно заказать услугу копирования сайта:

- студия SPECHEET (specheet.ru). Копирование (парсинг) — 790 рублей, от одного дня. Создание копии лендинга с нуля — от 7000 руб.;

- pro — сервис копирования сайтов (парсинга). Предлагает три тарифа: эконом за 390 руб. — копирование парсером с удалением трекеров и жучков; Эконом+ за 590 руб. — дополнительно редактируется форма приема заявок; Стандарт за 990 руб. — копирование с удалением трекеров, редактированием формы приема заявок, замена текста, контактов, установка Я.Метрики, залив на хостинг;

- веб-агентство pixel — предлагает комплексное копирование сайта (дизайна, форм, скриптов), цены рассчитываются индивидуально.

Гайд: как скачать весь сайт

Мы уже описали, как копировать сайт постранично с помощью встроенных инструментов браузера. Теперь подробная инструкция по использованию программ и сервисов.

Как скопировать сайт с помощью программы Cyotel WebCopy

Эту программу мы выбрали по трем причинам: она бесплатная, хороший функционал, почти как у платного софта, и приятный современный интерфейс (в сравнении с HTTrack, Teleport Pro, у которых возможности такие же).

Скачиваем установочный файл — переходим на официальный сайт, нажимаем кнопку “Download”.

Запускаем скачанный установщик, принимаем условия, нажимаем кнопку дальше.

Отмечаем необходимые настройки, нажимаем кнопку “Дальше” (Next).

Выбираем опции установки (создавать ли ярлык на рабочем столе), нажимаем “далее” и “установить”.

Запускаем приложение. Основные режимы работы программы:

- тестирование сайта;

- просмотр отчета по содержимому сайта;

- быстрое сканирование;

- копирование сайта.

Быстрое сканирование позволяет увидеть структуру страниц и их взаимосвязь. Через отчет можно оценить размер сайта и насколько много дополнительного контента будет загружено.

Чтобы скопировать сайт, достаточно в поле с адресом (website) вставить URL и нажать кнопку Копировать (Copy). Приложение автоматически создает структуру, редактирует ссылки. Все данные сохраняются в папку (Save folder), указанную под адресной строкой.

Готово, получаем дубликат сайта с преобразованным php-кодом в html-разметку. После завершения копирования в окне с данными можно посмотреть результаты копирования, список файлов, карту сайта.

Копирование сайта с помощью онлайн-сервиса Saveweb2zip

Процесс копирования с помощью сервиса упрощен, насколько возможно. Все четыре шага:

- переходим по ссылке saveweb2zip.com;

- вставляем в адресную строку url сайта или страницы;

- если нужно, настраиваем форму обратной связи;

- нажимаем кнопку “Скачать”.

Сервис сканирует сайт, автоматически формирует его зеркало и запускает скачивание. На этом копирование закончено. Вы получаете готовый для запуска дубликат. Скачанный zip-архив можно редактировать в визуальном редакторе или распаковать и запустить на сервере.

Скачивание изображений с сайта

И предустановленные программы, и онлайн-сервисы скачивают сайт целиком вместе с изображениями, скриптами, видео. Но картинки, как и видеоролики, копируются не всегда. Причина может быть как в установленных ограничениях по размеру файла, так и просто связана со сбоями в работе сервиса, ошибками в коде. Изображения могут физически находится на стороннем сайте (хостинге изображений или видеохостинге) и граббер проигнорирует их. В такой ситуации есть несколько решений:

- сканировать с помощью парсера, который умеет отдельно скачивать картинки и другой мультимедиа контент;

- заново сканировать сайт парсером, установив функцию “Скачать все страницы по ссылкам” (multiple mirror);

- копировать картинки вручную: открываем в браузере исходный сайт и скопированную на ПК копию, просматриваем страницы, где отсутствуют изображения, копируем картинки, кликнув по ним правой кнопкой мыши и выбираем команду “Сохранить изображение как…”, сохраняем в папку с контентом (img, pics, content или другое название) в раннее скачанном архиве;

- через инструменты разработчика: нажимаем в браузере Ctrl+Shift+I, открываем вкладку Sources, находим папку с изображением, копируем в папку с архивом.

Удобный функционал по скачиванию картинок реализован в Wget. Но приложение работает только через командную строку. Чтобы скачать изображения, запускаем программу через командную строку и вводим команду wget -A «*.jpg» -r https://www.yoursite.com

Как редактировать скопированный сайт

После скачивания есть несколько способов редактирования:

- открываем через блокнот или адаптированный блокнот для программистов (Notepad++, HAPedit или другой) и редактируем исходный код (вариант для настоящих гиков);

- через локальное приложение для создания и редактирования сайтов, например Adobe Dreamwiever или через WYSIWYG Web Builder. Впрочем, отредактировать скачанный лендинг можно даже через MS Word. Работает по принципу графического редактора (но не получится отредактировать формы захвата). Редактируем текст, стили, добавляем разделы как и при редактировании текстового документа;

- через веб-абминку CMS. Импортировать большой сайт на WordPress, Joomla или другую CMS не так легко (веб-разработчики новичкам рекомендуют работать с Modx Revo), но с лендингами, у которых минимум внешних ссылок, можно управиться, хотя это требует опыта.

Для редактирования лучше использовать специализированный редактор, хотя можно использовать и MS Word или его бесплатные аналоги, например WPS Office.

Подведем итоги

Скопировать сайт несложно, если это ресурс на несколько страниц без сложных форм и скриптов. Лендинги, магазины на одну страницу, визитки можно скачать, отредактировать и запустить на собственном сервере за несколько минут. Но когда дело касается сложных проектов с сотнями, тысячами страниц, корректно скопировать их достаточно сложно. И усилия на доработку часто нужны такие же, как на создание с нуля. Впрочем, для маркетологов и арбитражников парсеры заметно упрощают жизнь и позволяют намного быстрее запускать успешные рекламные кампании.

❗Читайте также: ТОП 10+🔥 парсеров для Инстраграм – подробный обзор сервисов.

*владелец Facebook и Instagram, компания Meta – запрещенная в РФ организация

Как скачать сайт целиком

Многие люди пользуются такой функцией, как скачивание веб-страниц. Большинство из них делают это с помощью специальной комбинации клавиш, которая позволяет скачивать сайты постранично. Однако существуют куда более практичные способы, которые позволяют скачать многостраничные сайты буквально за пару кликов мышкой.

- Скачать сайт целиком – зачем это нужно?

- Как скопировать сайт целиком – обзор доступных решений

- Скачать сайт целиком онлайн (постраничное сохранение) – преимущества, недостатки, особенности

- Как скачать сайт целиком с помощью специализированных программ?

- Программа для скачивания сайта целиком Cyotek WebCopy – преимущества, недостатки, особенности

- Программа для скачивания сайтов WinHTTrack WebSite Copier — преимущества, недостатки, особенности

- Teleport Pro — преимущества, недостатки, особенности

- Offline Explorer — преимущества, недостатки, особенности

- Webcopier — преимущества, недостатки, особенности

- Советы и выводы

Нередко возникает необходимость скачать сайт целиком, чтобы можно было просматривать его в режиме offline. Например, если на сайте много текстовой информации, проще скачать его полностью, чем создавать скриншот каждой отдельной страницы. Это может быть полезно, если необходимо скачать документацию, содержащую 500-1000 веб-страниц.

Также необходимость скачать сайт целиком возникает у программистов, а именно у тех, кто занимается frontend-разработкой. Благодаря этому специалисту не нужно каждый раз заходить на сайт, чтобы увидеть, как именно сверстаны его страницы. Он может скачать сайт и просматривать его в режиме offline.

Скачивание сайта целиком может понадобиться в целом ряде случаев. Другой вопрос заключается в том, как это можно сделать. Можно сохранять сайт постранично, но это занимает много времени и не всегда удобно. Гораздо проще скачать сайт с помощью специального программного обеспечения. Оба варианта подробно рассматриваются далее.

Об этом способе знают многие пользователи, так как данная возможность есть абсолютно во всех браузерах. Для того чтобы скачать сайт подобным образом, не нужно ничего устанавливать на свой ПК. Сохранить веб-сайт постранично можно с помощью комбинации клавиш «Ctrl» + «S». После нажатия нужных клавиш перед пользователем открывается окно, в котором нужно выбрать место для сохранения страницы сайта.

В теории все просто, но у подобного подхода есть один весьма значительный недостаток – скачивается лишь та страница сайта, на которой в данный момент находится пользователь. Если сайт многостраничный, то придется вручную скачивать каждую его страницу, что очень неудобно. Такой способ стоит использовать лишь для тех сайтов, которые состоят из 1-3 веб-страниц. В любых других случаях стоит воспользоваться специализированными программами.

С помощью специализированного программного обеспечения скачать сайт целиком проще и быстрее всего. Такой вариант стоит рассматривать, если сайты нужно скачивать на регулярной основе, а также если они состоят более, чем из 3-5 веб-страниц. Подобные программы бывают как платными, так и бесплатными. Но даже в некоторых бесплатных программах есть дополнительные функции, за использование которых придется платить. Ниже рассмотрены наиболее популярные программы для скачивания сайтов целиком.

Чтобы скачать сайт с помощью данной программы, достаточно установить ее на компьютер, вставить в специально отведенное поле ссылку на нужный сайт, выбрать папку для сохранения и нажать кнопку «Copy Website». Скачивание целого сайта в среднем займет 3-10 минут в зависимости от количества веб-страниц. Далее нужной зайти в выбранную ранее папку, найти и запустить файл под названием «index.htm».

Преимущества

- Современный и интуитивно понятный пользовательский интерфейс.

- Обширный функционал.

- Скачать целый сайт можно буквально в 2-3 клика мышкой.

Недостатки

- Программа не переведена на русский язык.

- Данная утилита работает только на операционной системе Windows.

Данная утилита считается одной из самых популярных в своем классе. Чтобы скачать сайт целиком, необходимо загрузить программу на ПК, указать название сайта, выбрать место для сохранения, ввести URL-адрес скачиваемого сайта, настроить фильтры и нажать кнопку «Готово».

Преимущества

- Можно переключить интерфейс программы на русский язык.

- Можно настроить различные фильтры (указать, что нужно скачивать, а что – нет).

- Интуитивно понятный пользовательский интерфейс.

- Существуют версии для различных операционных систем.

У некоторых пользователей после скачивания целого сайта с помощью данной программы некоторые веб-страницы могут отображаться некорректно. Это может быть связано с криво настроенными фильтрами либо с особенностями системы. Кроме того к недостаткам можно отнести низкую скорость скачивания.

Это одна из первых программ, предназначенных для скачивания веб-сайтов. Для использования нужно скачать утилиту, настроить фильтры, указать ссылку на скачиваемый сайт, выбрать папку для сохранения и нажать кнопку «Старт» в виде синего треугольника (располагается в панели управления программой).

Данная программа является одной из самых старых, поэтому с ее пользовательским интерфейсом сможет разобраться далеко не каждый. Кроме того, в Teleport Pro отсутствует возможность смены языка интерфейса на русский. Функционирует данная программа на платной основе, но есть возможность использовать программу бесплатно на протяжении пробного периода.

Данная программа считается одной из лучших, однако функционирует она на платной основе. Но это не помеха, если вам нужно скачать сайт несколько раз, так как новым пользователям предоставляется пробный период, который длится целый месяц. Программа предлагает стандартную, профессиональную, а также версию для предприятий. Самый дешевый пакет будет стоить порядка 4000 рублей, а самый дорогой – около 40 000 рублей.

Как и в программах, описанных выше, работа начинается с установки утилиты на ПК. Далее нужно придумать название для проекта, указать ссылку на нужный сайт, выбрать папку для скачивания, настроить фильтры и нажать кнопку «Загрузить».

Преимущества

- Есть русифицированная версия.

- Понятный пользовательский интерфейс.

- Есть многопоточная загрузка.

- Широкий функционал.

Недостатки

- Программа платная, причем даже самый дешевый вариант стоит достаточно дорого.

- Во время пробного периода действует лимит, который не позволяет создавать более 2000 проектов.

Как и две предыдущие утилиты, Webcopier функционирует на платной основе. Но создатели программы дают новым пользователям одну неделю пробного периода. Это одна из немногих программ, которая работает как на Windows, так и на mac OS. Работает программа по тому же принципу, что и все описанные выше варианты.

Преимущества

- Подходит практически для всех операционных систем.

- Множество фильтров.

- Интуитивно понятный и современный пользовательский интерфейс.

- При скачивании сайта пользователю показывается график, на котором видна скорость загрузки и прогресс.

- Наличие бесплатного пробного периода, как для стандартной, так и для профессиональной версии.

К недостаткам программы стоит отнести отсутствие русификации, а также сравнительно непродолжительный пробный период.

Существует сразу несколько способов, с помощью которых можно скачать сайт целиком. Если сайт небольшой (состоящий из 1-5 веб-страниц), то можно обойтись и простым постраничным скачиванием, которое работает в каждом браузере. Для этого достаточно использовать комбинацию клавиш «Ctrl» + «S» и выбрать место, куда загрузится сайт.

Если же ваша деятельность требует регулярного скачивания многостраничных сайтов, то проще один раз установить специализированную утилиту. Во многих случаях можно обойтись и бесплатными версиями программ, так как в их функционале присутствует все необходимое. Если же вас интересуют дополнительные инструменты, придется раскошелиться на платную версию. Но не стоит надеятся на то, что все скаченные сайты можно запустить в офлайне, программы хорошо подходят для скачки сайтов на не сложных движках.