Kubernetes — это открытое программное обеспечение для автоматизации развёртывания, масштабирования и управления контейнеризированными приложениями. Проект с открытым исходным кодом размещён на серверах Cloud Native Computing Foundation (CNCF).

Основы

Узнайте о Kubernetes и его фундаментальные понятия.

- Что такое Kubernetes

- Компоненты Kubernetes

- API Kubernetes

- Изучение объектов Kubernetes

Попробуйте Kubernetes

Пройдите серию уроков чтобы узнать, как развернуть приложение в Kubernetes.

- Привет, Minikube

- Краткий обзор основ

Настройка кластера

Получить Kubernetes, запущенный с учётом ваших потребностей и ресурсов.»

Узнайте, как использовать Kubernetes

Ознакомиться с распространёнными задачами и способами их быстрого решения.

- Установка Minikube

- Установка kubectl

Просмотр справочной информации

Обзор терминологии, синтаксиса командной строки, типов ресурсов API и документации по настройке инструментов.

- Глоссарий

- Обзор kubectl

- Шпаргалка по kubectl

Внести вклад в документацию

Внести свой вклад может любой человек, как начинающий, так и тот, кто уже давно пользуется продуктом.

- Участие для начинающих

- Руководство по оформлению документации

- Руководство по содержанию документации

- Использование шаблонов страниц

- Перевод документации

- Участие в SIG Docs

- Участие для продвинутых

Загрузка Kubernetes

Если вы хотите установить Kubernetes или обновить Kubernetes до последней версии, обратитесь к списку актуальных версий.

О документации

На сайте можно найти документацию для текущей и четырёх прошлых версий Kubernetes.

- Версии с поддержкой документации

Отметьте синее слово «Облачные вычисления CSDN«Подписывайтесь на нас!

Источник / Переводчик | Псевдоархитектор

Автор оригинала | Жером Петаццони

Хотите развернуть контейнерные приложения? Развертывание контейнерных приложений в Kubernetes всегда включает

Развертывание, вот все содержимое этого объекта.

Одна из первых команд Kubernetes, которую мы узнали, была kubectl run. Пользователи с опытом работы с Docker неизбежно будут использовать команду docker run для сравнения с этой командой. Вывод может быть таким: запустить контейнер — это очень просто.

Давайте посмотрим, что произойдет, когда мы запустим простую команду запуска kubectl:

$ kubectl run web --image=nginx

deployment.apps/web created

Что создается в кластере?

$ kubectl get all

NAME READY STATUS RESTARTS AGE

pod/web-65899c769f-dhtdx 1/1 Running 0 11s

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE

service/kubernetes ClusterIP 10.96.0.1 <none> 443/TCP 46s

NAME DESIRED CURRENT UP-TO-DATE AVAILABLE AGE

deployment.apps/web 1 1 1 1 11s

NAME DESIRED CURRENT READY AGE

replicaset.apps/web-65899c769f 1 1 1 11s

Мы видим не контейнер, а набор неизвестных объектов:

-

Deployment:web

-

ReplicaSet:web-65899c769f

-

Pod:web-65899c769f-dhtdx

Сервис kubernetes здесь можно игнорировать, он уже существует до того, как мы запустим команду.

Я просто хочу контейнер! Почему вы видите три разных объекта?

Проще говоря, эти объекты Kubernetes могут предоставлять приложениям поддержку постепенного развертывания, отката и масштабирования без остановки службы.

При первой встрече вам неизбежно будет любопытно: что происходит? Поняв эти вопросы, вы поймете роль и ценность существования каждого объекта.

Непрерывная интеграция повышает уверенность в коде. Чтобы распространить эту уверенность на процесс выпуска, операции развертывания нуждаются в большей гарантии.

Контейнер и контейнер

В Kubernetes самая маленькая единица развертывания — это не контейнер, а под. Pod — это группа контейнеров (конечно, в этой группе может быть только один), они работают на одном сервере и совместно используют некоторые ресурсы.

Например, контейнеры в Pod могут связываться друг с другом через localhost. С точки зрения сети все процессы в этих контейнерах являются локальными.

Но мы никогда не сможем создать независимый контейнер: ближайшая операция может заключаться только в создании Pod, содержащего только один контейнер.

Мы хотим, чтобы Kubernetes создавал NGINX. Полная строка гласит: «Мне нужен Pod, который содержит только один контейнер, и этот контейнер запускает образ nginx».

# pod-nginx.yml

# Create it with:

# kubectl apply -f pod-nginx.yml

apiVersion: v1

kind: Pod

metadata:

name: web

spec:

containers:

- image: nginx

name: nginx

ports:

- containerPort: 80

name: http

Есть только один модуль. Что случилось с ReplicaSet и Deployment?

Директивы и декларации

Kubernetes — это декларативная система (в отличие от императивной системы), что означает, что мы не можем отдавать ей команды. Мы не можем сказать: «Запустите этот контейнер». Все, что мы можем сделать, это описать, что нам нужно, а затем подождать, пока Kubernetes синхронизирует ожидаемый контент на основе существующего контента.

Например, мы можем сказать: «Мне нужен синий контейнер высотой 40 футов с желтой дверцей». Kubernetes будет искать этот контейнер для нас. Если он не может его найти, он создаст его; если он уже существует, но Это зеленая красная дверь, и Kubernetes поможет нам ее раскрасить; если уже есть контейнеры, полностью отвечающие требованиям, потому что существующий контент соответствует ожидаемому контенту, Kubernetes ничего не сделает.

Возвращаясь к теме программных контейнеров, мы можем сказать: «Я хочу Pod с именем web, в котором должен быть отдельный контейнер, запускающий образ nginx».

Если Pod не существует, Kubernetes создаст его. Если Pod, отвечающий нашим требованиям, уже существует, Kubernetes не должен предпринимать никаких действий.

Основываясь на этой идее, как масштабировать веб-приложения для удовлетворения рабочих потребностей нескольких контейнеров или модулей?

ReplicaSet упрощает процесс масштабирования Pod

Если у нас есть только один Pod, и мы хотим больше одного и того же Pod, мы можем сделать запрос в Kubernetes: «Нам нужен Pod с именем web2, конкретные требования: …», а затем повторить предыдущую спецификацию Pod. Повторите столько стручков, сколько хотите.

Это, очевидно, очень неудобно. Мы должны сами отслеживать все модули, чтобы гарантировать, что все они синхронизированы в правильном состоянии и соответствуют определенным спецификациям.

Kubernetes предоставляет абстракцию более высокого уровня для упрощения этого процесса: ReplicaSet. Объектная структура ReplicaSet очень похожа на Pod, но в ней также есть поле для количества реплик, которое используется для описания количества Pod, которое нам необходимо для соответствия спецификации.

С помощью ReplicaSet мы можем сказать Kubernetes: «Мне нужен ReplicaSet под названием web, который содержит 3 модуля, и эти модули соответствуют следующим спецификациям: …» Kubernetes подтвердит в соответствии с этой инструкцией, есть ли ровно три модуля, соответствующих спецификациям. Под. Если мы начнем с нуля, эти 3 модуля будут созданы. Если уже есть 3 модуля, ничего не произойдет — наши требования такие же, как статус-кво.

# pod-replicas.yml

apiVersion: apps/v1

kind: ReplicaSet

metadata:

name: web-replicas

labels:

app: web

tier: frontend

spec:

replicas: 3

selector:

matchLabels:

tier: frontend

template:

metadata:

labels:

app: web

tier: frontend

spec:

containers:

- name: nginx

image: nginx

ports:

- containerPort: 80

Масштабируемость и высокая доступность ReplicaSet

Мы можем изменить количество реплик существующего ReplicaSet, чтобы завершить масштабирование. Kubernetes будет создавать или удалять модули в соответствии с инструкциями по масштабированию, чтобы количество модулей соответствовало требованиям.

С точки зрения высокой доступности, поскольку Kubernetes будет постоянно отслеживать кластер, чтобы гарантировать, что указанное количество запущенных экземпляров поддерживается при любых обстоятельствах.

Если узел не работает и есть Pod, которому принадлежит сеть, Kubernetes создаст другой Pod, чтобы заменить его. Если узел не выключен, но с ним нельзя связаться или он не отвечает в течение определенного периода времени, то после того, как он снова станет доступен, появится дополнительный модуль, и Kubernetes приостановит работу модуля, чтобы убедиться, что номер соответствует требованиям.

Что происходит, когда вы изменяете определение Pod

Изменение определения Pod — не редкость. Например, мы часто хотим заменить образ контейнера новой версией.

Помните: миссия ReplicaSet состоит в том, чтобы «убедиться, что есть N модулей, соответствующих спецификации». Что произойдет, если мы изменим определение — внезапно не останется модулей, соответствующих новой спецификации.

На данный момент мы уже знаем, как работает декларативная система: Kubernetes немедленно создаст N Pod’ов, соответствующих новой спецификации. Старые модули будут существовать постоянно, пока мы не очистим их вручную.

Было бы хорошо, если бы CI / CD можно было использовать для автоматической очистки этих просроченных подов; было бы лучше, если бы новые поды можно было создавать более элегантным способом.

ReplicaSet, управляемый развертыванием

Упомянутая ранее необходимость является обязанностью Развертывания. На первый взгляд, спецификация развертывания очень похожа на ReplicaSet: она содержит спецификацию Pod и количество реплик. (Есть некоторые параметры, о которых мы поговорим позже)

# deployment-nginx.yml

apiVersion: apps/v1

kind: Deployment

metadata:

name: web

spec:

selector:

matchLabels:

app: nginx

replicas: 3

template:

metadata:

labels:

app: nginx

spec:

containers:

- name: nginx

image: nginx:1.7.9

ports:

- containerPort: 80

Deployment не несет прямой ответственности за создание и удаление модулей. Он делегирует эти задачи одному или нескольким ReplicaSets.

Когда мы создаем развертывание, оно создаст ReplicaSet со своей собственной спецификацией Pod.

При обновлении развертывания и изменении количества реплик обновленное содержимое будет передано в нижележащий ReplicaSet.

При изменении конфигурации

Когда требуется обновить спецификацию Pod, все становится интересно. Например, нам может потребоваться использовать новую версию изображения (потому что мы выпустили новую версию) или изменить параметры приложения (с помощью параметров командной строки, переменных среды или файлов конфигурации).

Когда мы обновляем спецификацию Pod, Deployment создаст новый ReplicaSet с новой спецификацией Pod. Первоначальное количество экземпляров нового ReplicaSet равно 0. Затем количество экземпляров ReplicaSet будет постепенно увеличиваться, постепенно уменьшая размер другого ReplicaSet.

Представьте, что перед нами находится микшерный пульт.Мы хотим одновременно добавить новый ReplicaSet и старый.

В течение всего процесса запрос отправляется в старый и новый ReplicaSet, и пользователь не почувствует прерывания обслуживания.

Панорама примерно такая, и есть много мелких деталей, которые делают весь процесс более надежным.

Поврежденное развертывание и обнаружение готовности

Если мы выпустим ошибочную версию, поскольку Kubernetes продолжит заменять старые модули новыми (ошибочными) версиями, это может привести к поломке всего приложения (Pod by Pod).

Если только мы не используем обнаружение готовности.

Обнаружение готовности — это процесс тестирования, добавленный в спецификацию контейнера. Это бинарный тест, и в результате получается только два «может работать» или «не может работать». Этот тест будет выполняться с заданным интервалом (по умолчанию каждые 10 секунд).

Kubernetes поддерживает три способа определения готовности:

-

Запустить команду в контейнере;

-

Отправить в контейнер HTTP (S) запрос;

-

Инициируйте TCP-соединение с контейнером.

Kubernetes будет использовать результаты теста, чтобы понять, готовы ли контейнер и его Pod принимать трафик. Когда мы запускаем новую версию, Kubernetes будет ждать, пока новый тест Pod не получит «готовый» результат, прежде чем перейти к следующему шагу.

Если Pod продолжает отказывать из-за проверок готовности, он никогда не сможет перейти в состояние готовности, и Kubernetes не перейдет к следующему шагу. Процесс развертывания остановится, и приложение будет продолжать работать со старой версией, пока мы не решим проблему.

Если проверки готовности нет, контейнер будет считаться готовым после успешного запуска. Поэтому лучше всего использовать обнаружение готовности для защиты бизнеса.

Используйте откат для быстрого восстановления после неудачных версий

В любой момент во время или после непрерывного обновления мы можем сказать Kubernetes: «Я передумал, пожалуйста, вернитесь к предыдущей версии этого развертывания». Эта операция изменит статус старого и нового ReplicaSet. Начиная с этого момента, количество экземпляров старой версии ReplicaSet будет увеличено до указанного значения, а количество экземпляров новой версии будет уменьшено.

Вообще говоря, это не ограничивается старым и новым ReplicaSet. В конечном итоге есть ReplicaSet, который считается «последней» версией. Мы можем использовать эту версию в качестве целевого ReplicaSet. Так называемая цель — это то, что мы хотим запустить, и это также версия, которую Kubernetes будет постепенно развивать. При этом может быть любое количество других версий ReplicaSet, соответствующих старой версии.

Например, мы запускаем 10 копий приложения версии 1, а затем начинаем развертывать версию 2. В какой-то момент у нас может быть запущено 7 модулей версии 1 и 3 версии 2. Если мы не хотим ждать полного выпуска версии 2, мы решаем выпустить версию 3. Когда была развернута версия 3, мы хотели вернуться к версии 1. На протяжении всего процесса Kubernetes будет корректировать количество реплик в каждой версии ReplicaSet по мере необходимости.

MaxSurge и MaxUnavailable

Kubernetes не обязательно обновляет один под за раз. Ранее мы упоминали, что Deployment имеет некоторые дополнительные параметры, включая MaxSurge и MaxUnavailable, эти два параметра определяют скорость процесса обновления.

Представьте себе две стратегии в процессе запуска новой версии:

-

Мы можем очень осторожно относиться к доступности приложения, поэтому решили запустить новый Pod, прежде чем закрывать старую версию. Только после того, как новый модуль будет запущен, запущен и готов, старый модуль будет отключен.

-

Неявным условием в приведенном выше предположении является наличие избыточных ресурсов в нашем кластере. Однако, если наш кластер уже полностью загружен и не может позволить себе потребление лишних Pod’ов, то мы, естественно, хотим отключить старый перед запуском нового.

MaxSurge указывает, сколько дополнительных модулей мы можем иметь во время непрерывного обновления; а MaxUnavailable показывает, сколько модулей мы можем допустить, не предоставляя услуги во время непрерывного обновления. Эти два параметра могут быть количеством модулей или процентом от количества экземпляров развертывания; оба параметра могут быть установлены на 0 (но не одновременно).

Затем посмотрите на общие значения этих двух параметров и их цель.

Значение 0 для параметра MaxUnavailable означает: «Не закрывайте старый модуль, пока новый модуль не будет запущен и не будет готов».

Установка MaxSurge на 100% означает: «запускать все новые модули немедленно», что означает, что у нас достаточно ресурсов, и мы надеемся завершить обновление как можно скорее.

Оценка этих двух параметров составляет 25% .Если мы обновим 100 Pod Deployment, 25 новых Old Pod будут созданы немедленно, а 25 старых Pod будут закрыты одновременно. Каждый раз, когда Pod готов к запуску, вы можете закрыть старый Pod. Каждый раз, когда старый модуль завершает процесс завершения работы (освобождая ресурсы), может быть создан еще один новый модуль.

Время презентации

Эффект от этих параметров легко наблюдать. Нам не нужно писать собственный YAML, определять проверки готовности и т. Д.

Все, что нам нужно сделать, это использовать недопустимое зеркало, например зеркало, которого не существует. Этот контейнер никогда нельзя запустить, и Kubernetes никогда не пометит его как готовый.

Если у вас есть кластер Kubernewtes (подойдет настольная версия одноузлового кластера Minikube или Docker), вы можете запустить следующие команды в разных терминалах, чтобы увидеть, что произойдет:

kubectl get pods -w

kubectl get replicasets -w

kubectl get deployments -w

kubectl get events -w

Затем используйте следующие команды для создания, масштабирования и обновления развертывания:

kubectl run deployment web --image=nginx

kubectl scale deployment web --replicas=10

kubectl set image deployment web nginx=that-image-does-not-exist

Вы увидите, что процесс развертывания остановлен, но доступно 80% емкости приложения.

Если мы запустим kubectl rollout undo deployment web, Kubernetes вернется к старой версии с помощью образа nginx.

Понять селекторы и теги

Как мы уже говорили ранее, задача ReplicaSet — обеспечить наличие N соответствующих Pod’ов. На самом деле это еще не все. Фактически ReplicaSet не заботится о спецификациях Pod, он заботится только о ярлыках.

Другими словами, независимо от того, работает ли Pod nginx, redis или что-то еще, все заботы о том, чтобы у них были правильные метки. В предыдущем примере теги примерно имеют вид run = web и pod-template-hash = xxxyyyzzz.

ReplicaSet содержит элемент селектора, содержимое является логическим выражением, функция аналогична SELECT в SQL, используется для выбора Pod, который соответствует требованиям. ReplicaSet гарантирует, что количество модулей правильное. При необходимости модули будут созданы или удалены, но существующие модули не будут изменены.

Будет предположение: Pod с этими тегами можно создать вручную, но с другими зеркалами (или разными конфигурациями) вы можете обмануть ReplicaSet.

На первый взгляд, это может быть большой потенциальной проблемой. Но на самом деле нам сложно случайно выбрать правильную метку, потому что метка содержит хеш-значение, рассчитанное согласно спецификации Pod.

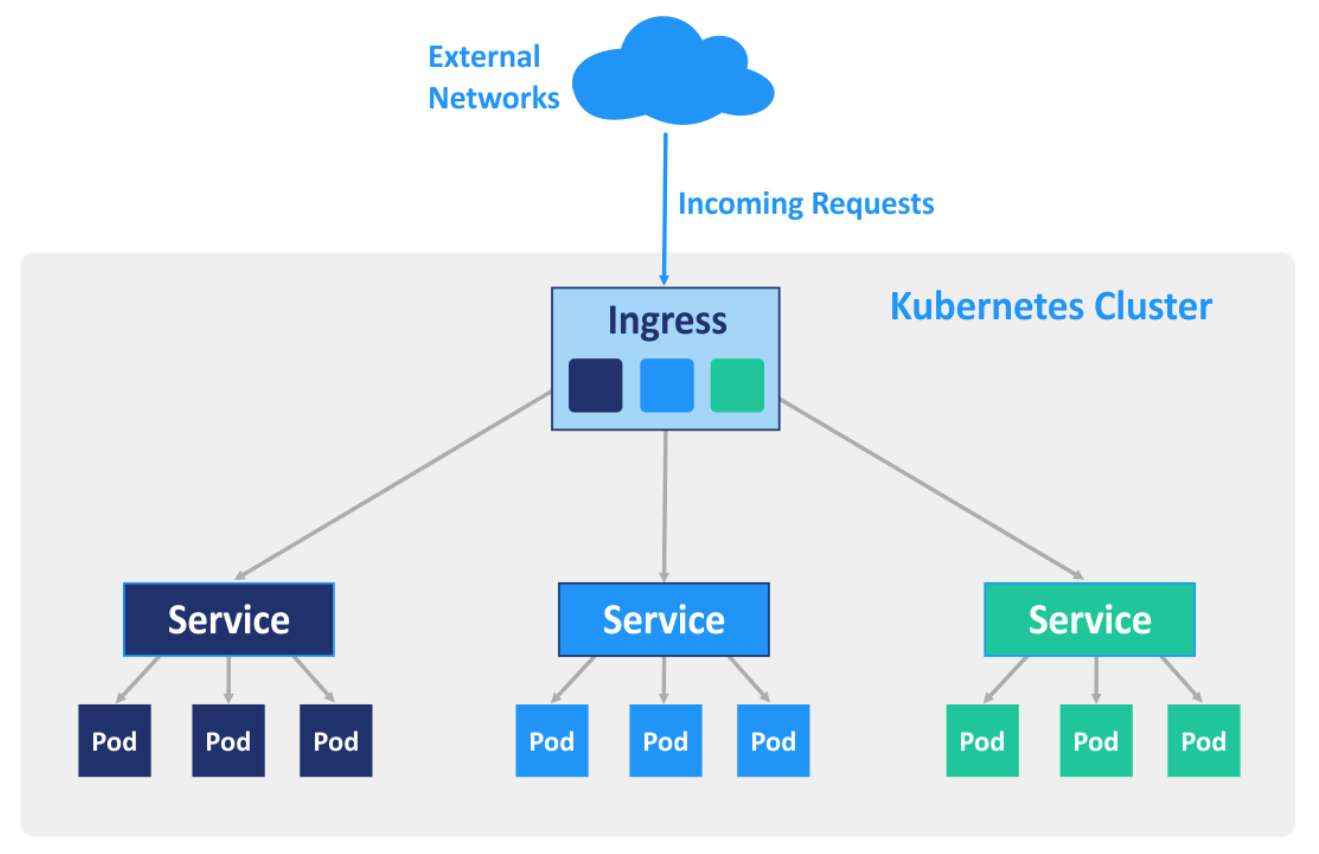

Балансировка нагрузки службы

Селектор также используется в Сервисе, который отвечает за внутреннюю и внешнюю балансировку нагрузки Kubernetes. Мы можем создать Сервис для Интернета:

kubectl expose deployment web --port=80

Эта служба будет иметь свой собственный внутренний IP-адрес (ClusterIP), и порт 80, подключенный к этому адресу, будет сбалансирован по нагрузке между всеми модулями этого развертывания.

Фактически, диапазон балансировки нагрузки этого соединения находится среди всех модулей, которые соответствуют селектору тега службы. Например, здесь соответствует run = web.

Когда мы редактируем развертывание и запускаем прокрутку, будет создан новый ReplicaSet. Этот ReplicaSet создаст модули, а новый тег Pod будет содержать run = web, поэтому эти модули будут автоматически получать трафик.

Это означает, что во время непрерывного обновления развертыванию не нужно перенастраивать или уведомлять балансировщик нагрузки, поскольку Pod запускается и останавливается. Балансировщик нагрузки автоматически выполняет задачи с помощью селекторов.

Если вас интересует внутренняя история обнаружения готовности: Pod будет добавлен в службу как действительная конечная точка только после того, как все контейнеры-участники пройдут проверку готовности. Другими словами, Pod начнет получать трафик только после того, как будет готов.

Расширенные стратегии развертывания Kubernetes

Есть некоторые вещи, над которыми мы надеемся получить больший контроль после выхода новой версии.

Две хорошо известные популярные технологии — это сине-зеленое развертывание и канареечное развертывание.

Сине-зеленое развертывание в Kubernetes

В сине-зеленом развертывании мы хотим немедленно переключить весь трафик со старой версии на новую, вместо постепенного переключения, как мы говорили ранее. У этого запроса может быть несколько причин:

-

Мы не хотим смешивать старые и новые запросы, мы надеемся максимально четко перейти со старой версии на новую;

-

Мы обновляем несколько компонентов (например, веб-интерфейс и серверную часть API) и не хотим, чтобы новая версия интерфейса соприкасалась со старой версией серверной части;

-

Если возникнет проблема, мы надеемся, что сможем откатиться как можно скорее, не дожидаясь перезапуска старой версии контейнера.

В Kubernetes вы можете создать несколько развертываний для завершения сине-зеленых развертываний и переключать их, управляя полем «Селектор» службы.

Следующая команда создаст два развертывания: синий и зеленый, используя зеркала nginx и httpd соответственно:

kubectl create deployment blue --image=nginx

kubectl create deployment green --image=httpd

Далее мы создаем Сервис, который сначала не будет отправлять трафик:

kubectl create service clusterip web --tcp=80

Затем мы обновляем селектор веб-сервисов: kubectl edit service web. Эта команда получит определение служебного объекта из Kunernetes API и откроет его в текстовом редакторе. Найдите в нем:

selector:

app: web

Замените паутину синей или зеленой или чем-нибудь еще. Сохранить и выйти. kubectl отправит обновленное определение в Kubernetes API, и теперь веб-служба будет отправлять трафик на конкретное развертывание.

Вы можете использовать веб-команду kubectl get svc, чтобы получить адрес службы, и использовать curl для доступа к ней.

Изменения, которые мы вносим в текстовом редакторе, также можно полностью выполнить с помощью командной строки, например, с помощью команды kubectl patch:

kubectl patch service web -p '{"spec": {"selector": {"app": "green"}}}'

Преимущество сине-зеленого развертывания заключается в том, что переключение трафика завершается почти сразу, а развертывание и откат можно легко выполнить, обновив определение службы.

Полное канареечное развертывание с Kubernetes

Иногда мы не хотим, чтобы тестовая версия затрагивала всех пользователей даже на короткое время. Так что мы можем частично выпустить новую версию. Например, мы развертываем два набора экземпляров, старый и новый, и 1% трафика отправляется на новую версию.

Далее мы будем наблюдать в данных мониторинга старой и новой версий. Если позволяют обстоятельства, вы можете двигаться дальше; если задержки, количество ошибок или другие вещи кажутся проблематичными, вернитесь к старой версии.

Благодаря метке и механизму селектора Kubernetes эту стратегию можно легко реализовать.

В предыдущем примере мы изменили селектор службы, а затем изменили метку Pod.

Например, установите селектор службы, позвольте ему выбрать модуль со статусом = включен, а затем пометьте конкретный модуль:

kubectl label pod fronted-aabbccdd-xyz status=enabled

Вы также можете поставить сразу несколько тегов:

kubectl label pods -l app=blue,version=v1.5 status=enabled

Удаление тегов также просто:

kubectl label pods -l app=blue,version=v1.4 status-

В заключение

Мы видели некоторые технологии безопасного развертывания, некоторые из которых могут легко сократить время простоя, вызванное развертыванием, что позволяет нам увеличить частоту развертывания, не беспокоясь о влиянии на пользователей.

Некоторые технологии закрепляют наши ремни безопасности, чтобы не допустить влияния проблемной версии на обслуживание. Есть и другие услуги, которые заставляют нас чувствовать себя непринужденно. Это немного похоже на кнопку сохранения в консольной игре — прежде чем пытаться выполнить сложные операции, мы знали, что если что-то пойдет не так, мы можем вернуться в прошлое.

Kubernetes позволяет командам разработки и эксплуатации использовать эти технологии для повышения безопасности развертывания. Если снизить фактор риска развертывания, развертывания можно будет проводить более часто и постепенно, а последствия изменений можно будет более удобно наблюдать.

Все это позволит быстрее получить доступ к нашим новым функциям и функциям восстановления, а также сделает наши приложения более удобными. Это также важная основа для достижения контейнеризации и непрерывной доставки.

Рекомендуемое чтение

-

Сборник, наиболее цитируемый с момента публикации в 2017 г. — Большие данные

-

Создана отечественная производственная, образовательная и исследовательская база RISC-V. Разделятся ли Intel, Arm и RISC-V на три части?

-

Контейнеризация небольших веб-сайтов (часть 1)

-

AbutionGraph: построение центра обработки данных нового поколения на основе графа знаний

-

Является ли китайский язык программирования «Mulan» еще одним браузером с «чужой» оболочкой?

-

У Ethereum 2.0 светлое будущее!

В первый день нового года отправляйтесь в Ухань!

Видео текст:

[00:00] => Kubernetes позволяет контейнеризировать приложения и упрощает развертывание в

[00:05] => производство. Богдан Стащук научит вас все, что вам нужно знать, чтобы начать

[00:09] => с помощью Kubernetes. Добро пожаловать в Kubernetes Для Начинающих. Kubernetes является стандартом де-факто для

[00:16] => внедрение контейнерных приложений в производство. Kubernetes имеет открытый исходный код

[00:22] => и поэтому он бесплатен для использования. Позвольте мне сначала представиться, прежде чем мы начнем этот курс.

[00:29] => Меня зовут Богдан Стащук, и я использую Докер и Kubernetes несколько лет на практике.

[00:36] => И я внедрил приложения реального мира в производство с использованием Kubernetes. Также,

[00:42] => Я преподаю онлайн и на своих личных сайтах , которые shoe.com Вы могли бы найти все курсы, которые

[00:47] => Я преподаю. Теперь давайте начнем с Kubernetes для начинающих, и я хотел бы начать с

[00:53] => план курса. Итак, что входит в этот курс, мы начнем с разговора о терминологии и

[01:01] => ключевые особенности Kubernetes. И вы узнаете, что такое кластер Kubernetes,

[01:07] => что такое узел и что такое спорт и что Kubernetes, по сути, делает это. Впоследствии,

[01:14] => мы немедленно погрузимся в практику и мы создадим небольшой кластер Kubernetes локально на

[01:20] => наши компьютеры. И впоследствии использовать такой кластер мы будем создавать и масштабировать различные развертывания.

[01:30] => Кроме того, мы создадим пользовательский докер изображение, переместите его в Docker Hub,

[01:35] => а затем создайте развертывание Kubernetes на основе этого специально созданного образа докера.

[01:44] => Помимо этого, мы также будем создавать службы и развертывания в Kubernetes с использованием конфигурации Yamo

[01:51] => файлы. Кроме того, мы будем соединять различные развертывания вместе, потому что это очень распространено

[01:58] => ситуация, когда вам приходится соединять разные приложения вместе по сети.

[02:05] => И Kubernetes, конечно, позволяет это делать. И также, наконец, мы изменим время выполнения контейнера

[02:13] => из докера в CRI o, потому что Kubernetes не привязан к докеру. Он также поддерживает

[02:20] => другие среды выполнения контейнеров, такие как CRI O и контейнер D. И вы могли бы использовать Kubernetes

[02:26] => абсолютно без докера. Одно единственное предварительное условие для этого курса необходимо ваше знакомство с докером,

[02:34] => Я предполагаю, что вы знаете, что такое контейнер Docker и как создавать различные контейнеры.

[02:40] => Хорошо, итак, давайте начнем с этого курса. И я хотел бы начать с определения

[02:45] => Kubernetes — это система оркестровки контейнеров. используя Docker, вы, конечно, могли бы

[02:52] => создайте контейнер на любом компьютере. Но, конечно, если вы хотите создать несколько контейнеров

[02:59] => на разных компьютерах на разных серверах у вас могут возникнуть проблемы. Kubernetes позволяет вам

[03:06] => для создания контейнеров на разных серверы, физические или виртуальные.

[03:11] => И все это делается автоматически без ваше вмешательство. Вы просто скажите Kubernetes, как

[03:17] => много контейнеров, которые вы хотели бы создать основанный на определенном изображении. Кубернетес — это

[03:23] => относительно одно хорошее слово, и оно состоит из 10 разных букв. НО ИТ-специалисты и

[03:29] => разработчики программного обеспечения относительно ленивы люди, и они не любят много печатать.

[03:34] => Вот почему награда за поиск в одиночку обычно сокращается только для трех персонажей. Но как это делается?

[03:41] => Давайте взглянем на это слово. между k и s на самом деле есть восемь разных букв.

[03:48] => Итак, номер восемь, вот почему кредитная премия Kubernetes будет сокращена всего до трех символов,

[03:55] => К восьми с. Таким образом, восемь представляет собой просто количество букв между начальным и конечным залогом

[04:03] => Вот так просто. Зная эту очень простую настройку мы могли бы продолжать. А теперь позвольте мне объяснить вам

[04:10] => о чем заботится Кубра. Таким образом, Kubernetes заботится об автоматическом развертывании контейнеризованного

[04:18] => приложения на разных серверах. И эти серверы могут быть как металлическими, так и физическими

[04:25] => серверы или виртуальные серверы. Опция виртуальных серверов, конечно, более распространена в настоящее время,

[04:31] => и почти никто сейчас не использует голые металлические серверы. Таким образом, Kubernetes позволяет выполнять автоматизированные

[04:38] => развертывания на разных серверах, которые могли бы находиться даже в разных уголках мира.

[04:45] => Помимо этого, Kubernetes также заботится о распределении ресурсов по

[04:50] => эти несколько серверов. И это позволяет вам эффективно использовать свои ресурсы

[04:57] => и избегайте недостаточного или чрезмерного использования ресурсов.

[05:03] => Также Kubernetes заботится об автоматическом масштабирование развернутых приложений в случае

[05:09] => вам нужно, например, увеличить количество контейнеров, которые должны быть созданы на разных

[05:15] => серверы. И все это делается автоматически. Вы просто скажите, когда вы хотите увеличить или уменьшить масштаб. Также,

[05:24] => Kubernetes заботится о мониторинге и проверка работоспособности контейнеров. И в случае

[05:31] => некоторые контейнеры выходят из строя по некоторым причинам Kubernetes может автоматически заменять вышедшие из строя контейнеры

[05:39] => и все это делается без вашего вмешательства. Как Я только что сказал вам, что Kubernetes развертывает контейнерные

[05:46] => приложения и, следовательно, он должен использовать определенную среду выполнения контейнера. И Догра — это просто

[05:54] => один из возможных вариантов Kubernetes в настоящее время, поддержка таких контейнерных сред выполнения Docker,

[06:02] => CRI O и контейнер D, а также среда выполнения контейнера поиска, например, как Docker или cRIO, должны

[06:10] => быть запущенным на каждом из серверов, входящих в кластер Kubernetes.

[06:17] => И главный результат здесь заключается в том, что Kubernetes можно использовать даже без докера вообще.

[06:23] => Он поддерживает другие среды выполнения контейнеров, такие как CRI O и контейнер D. И в конце этого курса,

[06:30] => Я продемонстрирую вам, как изменить время выполнения контейнера и перемещение из докера

[06:35] => например, критиковать О. Итак, теперь давайте начнем с терминологии и архитектуры Kubernetes.

[06:44] => И давайте начнем с того, что порт оба является самым маленьким подразделением в мире Kubernetes в Дакке.

[06:51] => контейнер — наименьшая единица измерения в Kubernetes pod — наименьшая возможная единица измерения и

[06:58] => контейнеры создаются внутри модуля. Так оба атома следуют внутри капсулы,

[07:06] => там могут быть контейнеры, один или даже несколько контейнеров. Кроме того, существуют

[07:12] => общие тома и общие сетевые ресурсы для пример, общий IP-адрес. Это означает, что

[07:21] => все контейнеры внутри одного контейнера общие объемы и общий IP-адрес.

[07:29] => И вы должны иметь это в виду, если хотите создать несколько контейнеров внутри одного и того же

[07:35] => порт. Наиболее распространенный сценарий, конечно, состоит в том, чтобы иметь всего один контейнер на порт. Но иногда

[07:42] => когда контейнеры должны быть скреплены вместе , и они сильно зависят друг от друга, и они

[07:48] => может существовать в одном и том же пространстве имен, возможно для сортировки нескольких контейнеров в одном порту.

[07:56] => Но опять же, один контейнер на порт — наиболее распространенный вариант использования.

[08:04] => Также, пожалуйста, имейте в виду, что каждый порт должен быть расположенный на одном и том же сервере, невозможно

[08:11] => распределите контейнеры с одного порта по разным серверам кластера Kubernetes,

[08:18] => один банк, один сервер. Итак давайте теперь взглянем на этот кластер Kubernetes что это за Kubernetes

[08:27] => кластер состоит из узлов, узел фактически является либо сервером с открытым исходным кодом, либо виртуальным сервером. И

[08:36] => вы могли бы включить несколько серверов saij в Кластер Kubernetes, и они будут расположены в

[08:43] => разные центры обработки данных в разных частях мира. Но обычно узлы, принадлежащие одному и тому же

[08:50] => Кластеры Kubernetes расположены близко друг к другу , чтобы выполнять все задания более эффективно.

[08:58] => Внутри узла есть порты, которые снова являются наименьшей возможной единицей в Kubernetes

[09:06] => и внутри каждого порта есть контейнеры обычно по одному контейнеру на порт

[09:12] => и такие платы сортируются по разным узлам , и все это делается автоматически для вас

[09:20] => Kubernetes выполняет эту работу. Но, конечно, ваша задача состоит в том, чтобы создавать такие узлы и создавать кластеры на основе

[09:29] => на этих узлах. Узлы не будут автоматически Формируйте класс или без вашего вмешательства.

[09:35] => Но после такой начальной настройки все будет автоматизировано и Kubernetes

[09:40] => будет автоматически развертываться как на разных узлы. Но как эти узлы на самом деле взаимодействуют

[09:47] => с Чарльзом или и как они управляются. В кластере Kubernetes был главный узел

[09:56] => а другие узлы в кластере называются рабочими узлы. и главный узел фактически управляет рабочим

[10:03] => узлы. И если задание главных узлов распределять например, загрузка через другие рабочие узлы

[10:12] => и все платы, связанные с вашими приложениями, развернуты на рабочих узлах,

[10:19] => главный узел запускает только системные порты, которые отвечают за фактические

[10:26] => работу кластера Kubernetes в целом, мы могли бы также сказать, что главный узел в

[10:31] => Кластер Kubernetes на самом деле является плоскостью управления, и он не запускает ваши клиентские приложения.

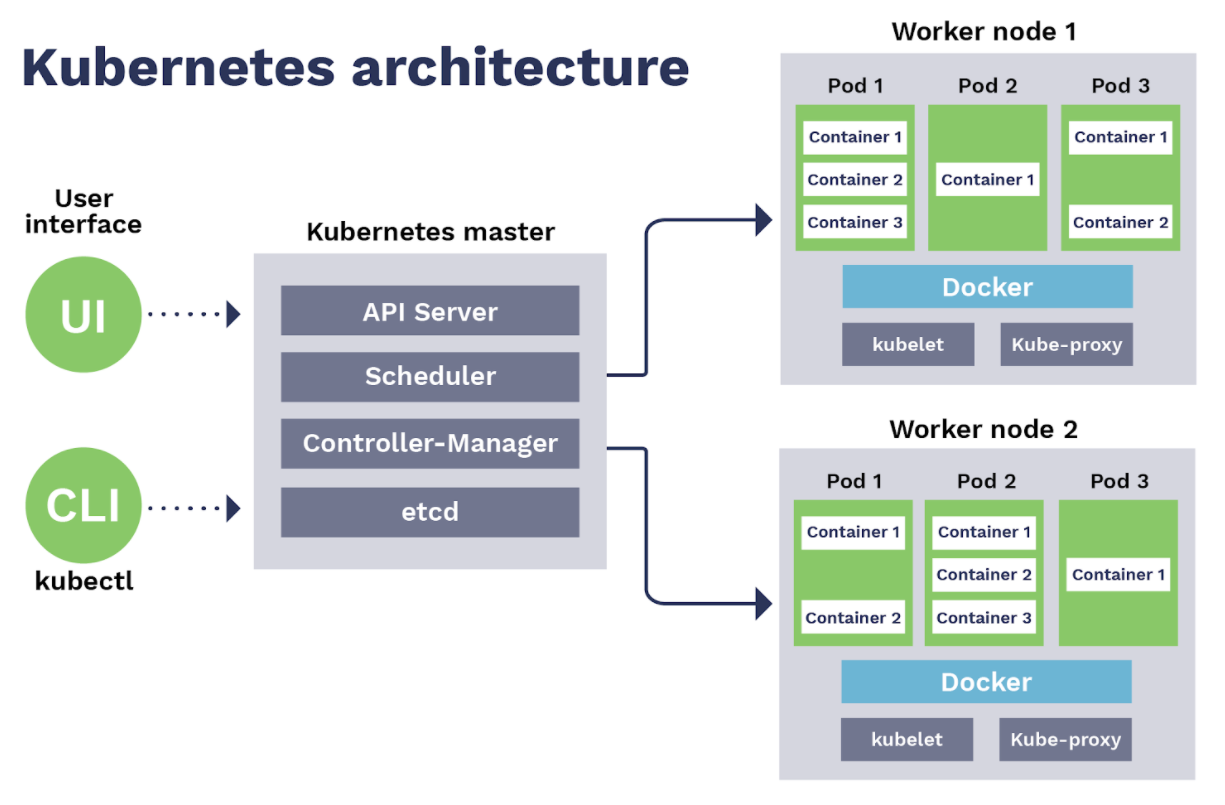

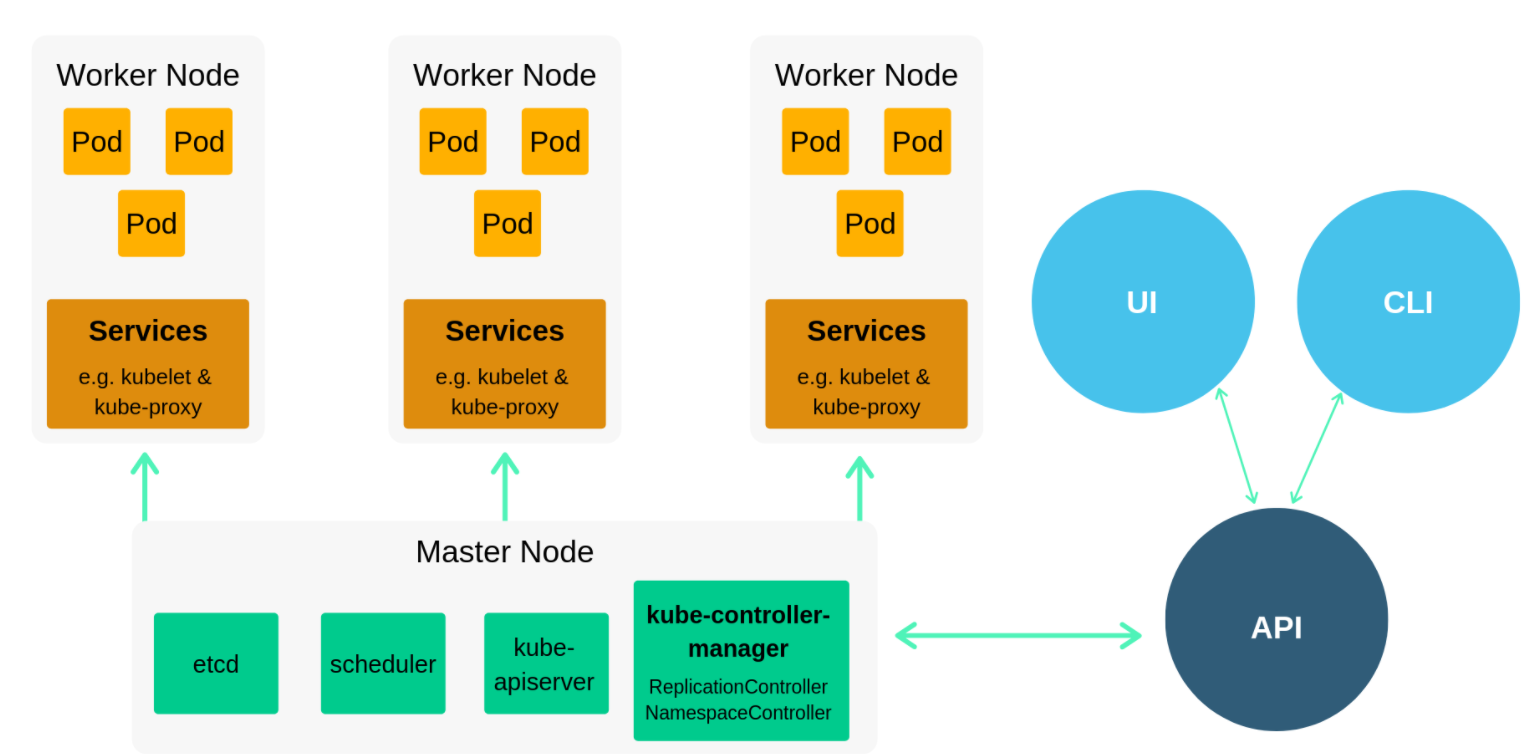

[10:40] => Итак, какие службы на самом деле работают на разных узлы? Давайте взглянем на эту диаграмму.

[10:48] => Существуют такие сервисы, как cubelet, прокси-сервер куба и среда выполнения контейнера, и эти сервисы

[10:56] => присутствует на каждом узле кластера Kubernetes. Вы уже знаете, что такое среда выполнения контейнера

[11:03] => среда выполнения контейнера запускает фактические контейнеры внутри каждого узла, и что существуют такие контейнеры

[11:10] => время выполнения в качестве докера CRI o или контейнера D. Существует также такой сервис, как cubelet. И

[11:19] => такая служба на каждом рабочем узле обменивается данными с помощью службы BI-сервера на главном узле.

[11:28] => Служба Di-сервера является основной точкой связи между различными узлами в мире Kubernetes.

[11:37] => Прокси-сервер куба, который также присутствует на каждом узле, отвечает за сетевую связь

[11:44] => внутри каждого узла и между узлами. Кроме того, существуют и другие услуги, которые присутствуют

[11:53] => на главном узле. И они являются планировщиком, и такая служба отвечает за планирование

[12:00] => и распределение Лорда между разными узлами в классе.

[12:05] => Кроме того, был диспетчер контроллера куба, и эта единственная точка, которая фактически управляет всем в

[12:12] => кластер Kubernetes. И это контролирует на самом деле что происходит на каждом из узлов кластера.

[12:20] => Кроме того, там был менеджер облачных контроллеров. И его работа заключается в взаимодействии с поставщиком облачных услуг

[12:27] => где вы на самом деле запускаете свой кластер Kubernetes, потому что обычно вы не создаете такие кластеры

[12:34] => самостоятельно, используя только свои собственные серверы. Вместо этого вы могли бы очень легко запустить Kubernetes

[12:40] => кластер от одного из облачных провайдеров, который фактически выполняет почти автоматизированные

[12:45] => создание всех узлов и соединений между такими узлами. И для этого у вас есть

[12:52] => чтобы запустить службу диспетчера облачных контроллеров на этом главном узле. Также, например, если вы хотите

[13:00] => создайте развертывание вашего приложения внутри кластера Kubernetes, которое будет открыто

[13:06] => к внешнему миру и разрешать подключения извне, вы также можете создать IP-адрес балансировщика нагрузки

[13:13] => адреса. И эти балансировщики нагрузки. IP-адреса обычно предоставляются конкретными облачными провайдерами.

[13:22] => Также на главном узле есть такой сервис, как etc. И это сервис, который на самом деле хранит

[13:29] => все журналы, относящиеся к работе всего кластера Kubernetes. И такие журналы хранятся там в качестве ключевых

[13:38] => пары значений. Кроме того, существуют другие службы, которые работают на главном узле, например, DNS

[13:46] => служба, которая отвечает за разрешение имен, весь кластер Kubernetes. И, например,

[13:52] => используя службу DNS, вы можете подключиться к определенному развертыванию по имени соответствующего

[13:59] => служба развертывания. И таким образом, вы могли бы соединять различные развертывания с заданием или

[14:06] => это разные сервисы, которые работают на разных узлах кластера Kubernetes. И

[14:13] => основной службой на главном узле является API Sara. И, кстати, с помощью этого сервиса API-сервера,

[14:21] => на самом деле вы могли бы управлять целым кластером Kubernetes. Как это делается? Это делается с помощью

[14:28] => cube CTL или управление кубом. А управление кубом — это отдельная командная строка

[14:37] => инструмент, который позволяет подключаться к определенным Кластер Kubernetes и управляйте им удаленно.

[14:45] => И cube CTL может работать даже на вашем локальном компьютер. И используя такой инструмент cube CTL, вы могли бы

[14:52] => управляйте удаленным кластером Kubernetes. И используя такой инструмент, вы фактически подключаетесь с помощью REST API

[14:59] => к службе сервера API на главном узле. И такое общение происходит по протоколу HTTPS. Между прочим,

[15:08] => другие узлы в кластере, я имею в виду рабочие узлы , взаимодействуют с главным узлом таким же образом.

[15:15] => Это означает, что с помощью такого инструмента cube CTL вы можете управлять любым удаленным кластером Kubernetes.

[15:22] => Это для обзора архитектуры Kubernetes, и теперь вы знаете, что кластер Kubernetes

[15:27] => состоит из узлов, и один из узлов является главным узлом, и он управляет нашими другими узлами,

[15:34] => которые называются рабочими узлами. На каждом узле есть доски, и доски классифицированы

[15:41] => автоматически с помощью Kubernetes. А внутри порта есть контейнеры, обычно просто

[15:47] => единый контейнерный порт. Кроме того, пожалуйста, имейте в виду, что все контейнеры внутри порта

[15:53] => общее пространство имен для этого порта, например тома или сетевой IP-адрес. Кроме того, оба наших самых маленьких подразделения

[16:03] => в Kubernetes, и могут быть созданы порты, которые может быть удален, может быть перемещен с одного узла на

[16:10] => другой. Это происходит автоматически без ваше вмешательство. Но вы должны спроектировать

[16:16] => ваше приложение с учетом этого, оба могут быть удалено в любой момент времени. Кроме того, существуют

[16:24] => различные службы, работающие на разных узлы. Например, служба сервера API является центральной

[16:31] => точка связи между главным узлом и другими рабочими узлами. А также используя такой

[16:38] => сервисное обслуживание, вы действительно могли бы управлять фактическим Кластер Kubernetes с использованием инструмента cube CTL, который имеет

[16:45] => быть установленным, например, на вашем компьютере , если вы выполняете управление со своего компьютера.

[16:51] => Хорошо, я не хочу углубляться в детали Kubernetes, потому что

[16:56] => это очень сложный инструмент. И я хочу вместо этого больше сосредоточиться на практических задачах.

[17:03] => Вот почему сейчас, после такого обзора, мы вместе с вами погрузимся в практику и выполним

[17:10] => различные практические задачи вместе. Например, мы будем создавать развертывания, сервисы, масштабировать

[17:16] => развертывания, создайте пользовательский образ Docker и создайте развертывание на основе этого образа и так далее.

[17:23] => Для того, чтобы выполнять все практические задачи вместе со мной вам придется установить некоторые программы

[17:29] => на вашем компьютере. И теперь, когда мы говорим о необходимое программное обеспечение, и сначала мы должны создать

[17:35] => фактический кластер Kubernetes, где мы будем создавайте различные развертывания. Конечно,

[17:41] => вы можете создать кластер, используя сервисы одного из облачных провайдеров, таких как Amazon Web Services,

[17:47] => или Google Cloud, но вам придется заплатить за такое обслуживание. Если вам нужно бесплатное решение, вы могли бы

[17:54] => создайте класс для локально на вашем компьютере. И для этого существовал такой инструмент, как мини-куб.

[18:01] => И такой инструмент, по сути, создаст всего один узловой кластер. И этот узел будет

[18:06] => быть как рабочим узлом, так и главным узлом. Но для тестовых развертываний и в качестве игровой площадки,

[18:14] => это работает довольно хорошо, и все это бесплатно и будет запущено на вашем локальном компьютере.

[18:21] => Для успешного запуска mini cube у вас есть для использования виртуальной машины или диспетчера контейнеров.

[18:28] => И поддерживаются следующие менеджеры виртуальных машин или контейнеров

[18:33] => VirtualBox, VMware, Docker, Hyper V или parallels. Есть и другие доступные варианты.

[18:43] => Но вы должны использовать один из таких вариантов. Для того, чтобы фактически создать виртуальный узел,

[18:49] => который будет запускать все оба в вашем кластере Kubernetes.

[18:54] => Я предлагаю вам продолжить работу с Hyper V, если вы пользователь Windows. И если вы являетесь пользователем Mac OS,

[19:02] => вы могли бы использовать welchol box, он бесплатный и с открытым исходным кодом, или вы могли бы использовать VMware или

[19:09] => параллели. Кстати, также была возможность запустить mini cube в качестве контейнера внутри докера.

[19:19] => Конечно, если у вас на компьютере уже установлен Docker, вы можете использовать его для того, чтобы

[19:25] => для создания кластера Kubernetes с использованием mini cube и, по сути, он создаст отдельный докер

[19:31] => контейнер и внутри этого контейнера будут созданы все оба. Но я лично не рекомендую

[19:37] => для вас, чтобы продолжить работу с опцией Docker, потому что были некоторые ограничения. Например, я был

[19:42] => не удается изменить среду выполнения контейнера внутри контейнера Docker на CRY или контейнер D.

[19:50] => И поэтому я рекомендую вам использовать другие варианты, которые упомянуты здесь.

[19:55] => Кстати, Hyper V доступен в Windows компьютеры из коробки, и И вы могли бы

[20:00] => используйте его в качестве диспетчера компьютеров Butoh для запуска узла mini cube. Подведем итог с помощью мини-куба,

[20:07] => вы создадите кластер Kubernetes с одним узлом . Но, как я уже упоминал ранее,

[20:12] => вы должны использовать определенный инструмент для управления этот кластер. И этот инструмент называется cube CTL.

[20:20] => Кстати, cube CTL входит в состав mini cube. Но если вы хотите использовать такую включенную версию,

[20:27] => вам придется вводить команды CTL mini cube cube, это неудобно. Поэтому я рекомендую

[20:33] => вы должны установить cube CTL отдельно. И используя отдельная установка, вы сможете, из

[20:39] => курс для управления другими кластерами Kubernetes, которые расположены, например, в Amazon Web Services.

[20:46] => Итак, cube CTL также является одной из программ, которые вы необходимо установить на свой компьютер. Конечно, я буду

[20:53] => объясню вам, как установить mini cube и cube CTL. Кроме этого, мы также сделаем некоторое кодирование

[21:01] => в этом практическом курсе. И для этого у вас есть использовать один из редакторов кода, и я рекомендую

[21:08] => для вас, чтобы установить код Visual Studio, он открыт исходный код и бесплатный для использования. И если вы еще не сделали

[21:15] => установил его, пожалуйста, продолжайте и установите его. Кроме того, он имеет множество различных расширений, и один

[21:21] => одним из них является расширение Kubernetes. И используя такие расширение, которое вы могли бы очень быстро, например, отлично

[21:27] => Файлы конфигурации Yamo для ваших развертываний и служб в Kubernetes. Это все, что ты

[21:34] => необходим для этого курса мини-куб cube CTL и визуальный Студийный код. Теперь давайте начнем с практических

[21:40] => часть. И я надеюсь, что вам понравится этот курс. И мы начнем с установки мини-куба

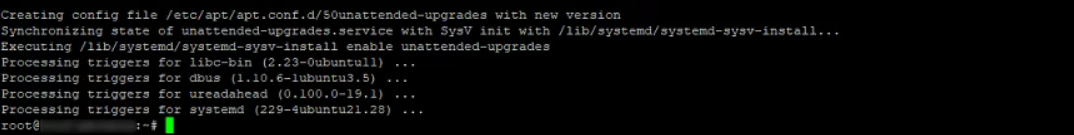

[21:47] => и кубический CTL. Хорошо, ребята, теперь давайте начнем с практической части курса. И мы будем

[21:53] => начните с установки communication cube вместе с cube CTL. Но сначала я хотел бы попросить вас

[22:00] => перейдите к kubernetes.io . Это основной сайт , посвященный Kubernetes в целом, и на нем есть

[22:08] => вся документация, связанная с настройкой кластеров мини-кубов, созданием развертываний и т.д.

[22:14] => Пожалуйста, нажмите здесь на документацию. И здесь , в левом разделе, перейдите к началу работы.

[22:22] => И здесь вы можете прочитать, как вы могли бы создать среду обучения.

[22:26] => Наряду с этим вы также можете найти информацию как создать производственную среду. Но мы есть

[22:32] => сейчас заинтересован в создании локального кластера Kubernetes. И для этого мы будем использовать мини-куб.

[22:40] => А также мы установим трубный CTL. Вот почему а пожалуйста, нажмите здесь на эту гиперссылку для установки инструментов.

[22:48] => И найдите инструкции по установке cube CTL в разных операционных системах, пожалуйста, выберите

[22:56] => твой. Я выберу Mac OS здесь. И если вы являетесь Пользователь Mac OS, вы могли бы очень легко установить cube

[23:04] => CTL с использованием доморощенного позвольте мне продемонстрировать вам, как чтобы сделать это. Позвольте мне нажать на эту опцию. Запустить

[23:10] => команда установки brew install cube CTL Позвольте мне скопируйте эту команду и откройте терминал, который я использую

[23:17] => элемент на Mac и вставьте эту команду здесь. Давайте идите вперед и установите cube CTL. Пакет надзирателя

[23:30] => и был установлен cube CTL. Позвольте мне проверить версию cube CTL. Для этого я мог бы использовать

[23:37] => в этой версии CTL командного куба есть настольный клиент. Позвольте мне ввести его здесь.

[23:44] => И я вижу, что cube CTL был установлен успешно. И там была клиентская версия

[23:51] => мажор один и минор 22. И вот на самом деле была установлена точная версия.

[23:57] => Хорошо, если вы пользователь Windows, я рекомендую вам установить cube CTL с помощью диспетчера пакетов,

[24:06] => вы можете перейти к установке и настройке cube CTL на Windows и здесь выберите опцию установить в Windows

[24:13] => используя шоколад или совок. Нажмите на эту опцию , и здесь вы найдете инструкции по установке

[24:21] => различные пакеты, использующие диспетчер пакетов chocolaty или установщик командной строки scoop, я рекомендую

[24:27] => вам нужно установить менеджер пакетов chocolatey. Для того , чтобы сделать это, пожалуйста, откройте эту ссылку здесь и найдите

[24:35] => инструкции по установке этого менеджера пакетов для окон. Используя тот же менеджер пакетов, что и вы

[24:42] => также можно было бы очень легко установить mini cube. Так пожалуйста, продолжайте и установите этот менеджер пакетов

[24:48] => а затем следуйте этим инструкциям о том, как чтобы установить cube CTRL в Windows. Используйте только один

[24:56] => выполните эту команду, а затем проверьте, что куб CTL доступен с помощью этой команды. Все в порядке.

[25:04] => После этого я предполагаю, что cube CTL уже доступен на ваших компьютерах.

[25:09] => А теперь давайте продолжим и установим mini cube. Иди вернитесь на страницу «Начало работы» и здесь прокрутите вниз

[25:15] => перейдите в среду обучения и нажмите на гиперссылку установленные инструменты. В этом вы найдете игру

[25:22] => что вам нужно установить cube CTL. Это то, что мы просто сделали это вместе. И если вы прокрутите страницу вниз, вы увидите

[25:29] => найдите варианты, которые вы могли бы использовать для создания локального кластера Kubernetes для обучения и

[25:36] => цели тестирования. В настоящее время существуют такие инструменты , как kind, и они позволяют создавать Kubernetes

[25:43] => кластеризуйте локально на вашем компьютере, но для этого требуется Докер. Также есть мини-куб и куб ADM.

[25:51] => Мы будем использовать мини-куб на протяжении всего этого курса. Вот почему давайте начнем с установки

[25:58] => из мини-куба. Для этого не требуется докер. Но для этого требуется одна из виртуальных машин

[26:05] => менеджерам нравятся параллели Hyper V. Или, если вы хотите, вы также можете использовать Docker, пожалуйста, перейдите к

[26:14] => по этой ссылке мини-куб, вы можете просто ввести мини -куб в строке поиска Google и нажать на

[26:20] => первый результат на выходе. И здесь вы найдете документация о том, как начать работу с mini cube,

[26:28] => пожалуйста, нажмите на эту ссылку, чтобы начать. И здесь вы могли бы прочитать о мини-кубе и

[26:35] => это в основном создаст кластер Kubernetes локально на вашем компьютере.

[26:39] => И он будет содержать только один узел, который будет действовать как главный узел, так и рабочий узел.

[26:46] => И все, что вам нужно для того, чтобы создать такой кластер — это всего лишь запуск мини-куба с одной командой

[26:52] => вот так просто. Но для того, чтобы успешно создайте кластер мини-кубов, вам необходимо установить

[26:59] => один из менеджеров контейнеров или ваших виртуальных машин , таких как Docker, HyperCard, Hyper V parallels и

[27:06] => так далее. Я уже говорил вам, что если вы являетесь пользователем Windows, я рекомендую вам использовать Hyper V

[27:12] => потому что он доступен в Windows из коробки. Если вы являетесь пользователем Mac, я рекомендую вам перейти

[27:19] => впереди либо опция will toolbox, либо parallels , либо VMware Fusion beautiful box для нас бесплатна.

[27:28] => Поэтому, если вы не хотите ничего покупать для Менеджер виртуальных машин, я рекомендую вам перейти

[27:33] => вперед с этим вариантом. Кроме того, внутри контейнера можно создать мини-кубический кластер

[27:41] => Контейнер Docker, и для этого вы можете просто установить Docker. Но я лично не рекомендую

[27:46] => для вас, чтобы продолжить этот вариант, потому что существуют некоторые ограничения при запуске таких

[27:51] => стеклянная дверь внутри контейнера докера. Все прямо здесь, ниже, вы можете узнать, как установить

[27:57] => мини-куб на разных операционных системах Linux, Mac OS и Windows. Если вы являетесь пользователем Windows,

[28:03] => вы могли бы так же, как и в случае cube CTL, использовать choco латте, пожалуйста, выберите этот вариант и введите просто

[28:12] => одна команда choco установите mini cube просто , и вы получите установленный mini cube

[28:17] => на компьютере с Windows, но я использую Mac OS Вот почему я выберу этот вариант и выберу

[28:23] => доморощенный, и для того, чтобы установить mini cube с помощью brew, я мог просто ввести только одну команду brew

[28:29] => установите мини-куб. Позвольте мне пойти дальше и установить это с помощью варева. Давайте вернемся к терминалу и

[28:36] => здесь основана команда brew install mini cube. Давайте подождите немного, пока это не будет установлено. Хорошо, мини-куб

[28:45] => был установлен, и теперь я мог проверить его версию версия мини-куба. Вот была версия в моем случае

[28:53] => и вы также можете ввести команду СПРАВКИ mini cube , чтобы найти список всех доступных команд

[29:00] => в мини-кубе. А если вы прокрутите страницу вверх, то узнаете, как запустить локальный кластер Kubernetes,

[29:07] => получите статус локального кластера Kubernetes, остановите стекло или удалите и откройте панель мониторинга.

[29:15] => Также вы можете приостановить и отключить кластер Kubernetes прямо сейчас давайте создадим настоящий кластер

[29:23] => Я предполагаю, что теперь вы также установили mini cube и cube CTL. Эти инструменты представляют собой два отдельных

[29:30] => инструменты. Вот почему они доступны в виде двух отдельные команды mini cube и cube CTL.

[29:38] => А теперь давайте продолжим и создадим кластер Kubernetes . Для этого, пожалуйста, используйте команду mini cube

[29:45] => начните, но сначала давайте введем статус мини-куба , чтобы проверить текущее состояние кластера

[29:52] => статус мини-куба. Здесь я вижу , что профиль mini cube не найден

[29:56] => вокруг профиля мини-куба эти два профиля , а также лед, чтобы начать кластер,

[30:01] => Я должен запустить команду запуска мини-куба. Вот что мы собираемся сделать это прямо сейчас, давайте создадим кластер

[30:08] => старт мини-кубика. И здесь я хотел бы спросить вы должны запустить кластер мини-кубов с опцией.

[30:16] => И эта опция будет драйвером, и вы должны пишите с двумя тире, это водитель. И здесь

[30:23] => будет знак равенства. И после этого вы должны указать виртуальную машину или диспетчер контейнеров,

[30:29] => который вы бы использовали для создания кластера мини-кубов. Я уже упоминал об этом раньше

[30:35] => если вы являетесь пользователем Windows, я рекомендую вам использовать Hyper V. Поэтому, если вы используете Windows,

[30:41] => просто введите здесь, Hyper V вот так, все в нижнем регистре без тире есть этот знак равенства водителя.

[30:50] => V. Если вы являетесь пользователем Mac OS, вы могли бы пойти вперед с любым из этих вариантов VirtualBox

[30:56] => parallels или VMware Fusion, я буду использовать Виртуальный ящик. Если у вас нет с собой набора инструментов,

[31:03] => пожалуйста, продолжайте и установите его, и вот ваш набор инструментов, и нажмите на первую ссылку здесь.

[31:13] => Ваш набор инструментов свободен. А вот ссылка, по которой вы можете скачать свой набор инструментов. Так что, если ты этого не сделаешь

[31:20] => у вас есть свой набор инструментов, и если вы пользователь Mac OS, пожалуйста, скачайте свой набор инструментов.

[31:27] => Хорошо, я уже установил ваш набор инструментов. Вот почему я просто уточню

[31:32] => это как биография для этого варианта драйвера здесь. Поэтому я наберу Vertol box.

[31:40] => Давайте продолжим и создадим кластер мини-кубов внутри виртуальной машины VirtualBox в моем случае,

[31:46] => создание виртуальной машины toolbox количество процессоров, памяти и диска. Это займет некоторое время

[31:54] => Позвольте мне немного подождать, виртуальная машина была создана. И теперь я вижу сообщение о подготовке Kubernetes

[32:00] => на Докере. И это означает, что по умолчанию мы будет использовать среду выполнения контейнера Docker для

[32:06] => запуск реальных контейнеров внутри кластера Kubernetes. Здесь я вижу шаг создания сертификатов

[32:14] => и клавиши, загружающие плоскость управления. И, наконец, в конце я вижу, что CTL done cube не настроен на

[32:22] => используйте кластер мини-кубов. И это означает, что вы не нужно ничего делать для подключения

[32:28] => от cube CTL до фактического кластера мини-кубов. Это соединение было создано автоматически для вас

[32:34] => во время создания кластера мини-кубов. Кроме того, в моем случае я вижу такое предупреждение,

[32:41] => вы выбрали драйвер панели инструментов, но есть лучшие варианты для повышения производительности

[32:45] => и поддержка рассмотрите возможность использования другого драйвера Гиперкарты parallels или VMware. Теперь давайте на самом деле

[32:52] => проверьте статус этого кластера Kubernetes. И для этого вы можете ввести статус командного мини-куба.

[33:00] => И вы должны понять, что хозяин ироничен cubelet запущен, сервер API запущен и

[33:06] => конфигурация куба настроена. Это нормальное состояние кластера мини-кубов. И теперь мы на самом деле

[33:13] => возможность создавать службы развертывания и так далее внутри этого кластера мини-кубов. Кроме того, я бы

[33:20] => хотел бы упомянуть, что у меня не работает докер прямо сейчас. Я на самом деле установил его на этом

[33:26] => компьютер. Но здесь, на панели значков, я не вижу значка докера, это означает, что теперь Kubernetes включен

[33:33] => мой локальный компьютер не использует фактическую версию или установку на моем компьютере. Но есть Докер

[33:42] => который работает внутри узла мини-куба. И это то, что мы проверим прямо сейчас. Так как вы

[33:50] => уже известно, что каждый узел в кластере Kubernetes — это просто виртуальный или физический сервер. В нашем

[33:56] => в этом случае мы создали виртуальный сервер, и вы можете подключиться к любому серверу с помощью протокола SSH.

[34:04] => И для того, чтобы подключиться через SSH, нам сначала нужно чтобы узнать, какой IP-адрес был назначен

[34:11] => Узел Kubernetes. Мини-куб предоставляет команду для этого. Просто введите IP-адрес mini cube, и вы получите

[34:18] => посмотрите, какой IP-адрес был назначен виртуальному машина, на которой работает наш узел Kubernetes, который

[34:26] => был создан mini cube, в моем случае он был адресом , просто возьмите этот IP-адрес, а затем,

[34:33] => введите SSH Docker это имя пользователя по умолчанию имя пользователя для такого узла такая красивая Сара

[34:42] => и после добавления подпишите баланс мини -кубической заметки, а затем, пожалуйста, нажмите enter

[34:56] => вам будет предъявлен отпечаток пальца, пожалуйста продолжайте и введите здесь в качестве вывода средств такие

[35:02] => отпечаток пальца. После этого вам будет предложено ввести пароль по умолчанию для mini cube. Ваш

[35:09] => эта машина является пользователем постоянного тока, пожалуйста, продолжайте и введите это здесь. Таким образом, имя пользователя темнее, а пароль — DC

[35:18] => был введен пароль пользователя. И теперь я см. приветственное приглашение из мини-куба

[35:23] => Сара. Теперь я нахожусь внутри узла Kubernetes. И первая команда, которую я хотел бы задать

[35:32] => вы должны войти сюда в докер ps. Такая команда перечислит все, что вы запускаете в контейнерах Docker.

[35:39] => А вот и куча разных контейнеров которые были созданы внутри узла Kubernetes.

[35:46] => И еще раз, пожалуйста, напомните, что Docker является средой выполнения контейнера по умолчанию для Kubernetes.

[35:53] => Существуют и другие среды выполнения контейнеров, такие как CRI O и контейнер D. Но здесь мы видим, что там

[36:00] => представляют собой кучу разных контейнеров, которые были созданный докером внутри заметки mini cube.

[36:06] => И, например, здесь я вижу такой контейнер, как сервер cube API, планировщик кубов и так далее.

[36:14] => Напомним, что мы обсуждали с вами различные сервисы, работающие на главных узлах

[36:19] => и рабочие узлы. И эти услуги на самом деле работает внутри контейнеров, как вы видите справа

[36:26] => теперь здесь. Кроме того, существуют такие контейнеры, как поставщик прокси-хранилища cube, или, например,

[36:34] => основной DNS. И опять же, у каждого контейнера есть свое предназначение. Вот как вы могли бы проверить, какой

[36:42] => контейнеры были созданы внутри узла Kubernetes . Но если я введу здесь команду cube CTL, я

[36:49] => появится сообщение об ошибке команда cube CTL не найдена, так как команда cube CTL недоступна внутри

[36:56] => Куб узла Kubernetes cube CTL — это внешний инструмент, который используется для управления кластером Kubernetes

[37:03] => таким образом, давайте теперь выйдем из этого SSH-соединения соединение было закрыто. А теперь давайте воспользуемся кубом

[37:09] => Здесь доступна команда CTL куба роста CTL локально на наших компьютерах, потому что мы установили

[37:16] => cube CTL прежде чем давайте сначала проверим класс на предмет информации cube CTL кластеризует эту информацию, и я получаю следующее

[37:25] => выходная плоскость управления Kubernetes запущена. И здесь я вижу IP-адрес, который мы только что видели после

[37:32] => ввод IP-команды mini cube. В вашем случае, конечно, такой IP-адрес будет другим.

[37:38] => А также я вижу, что основная служба DNS также работает. Это означает, что теперь мы действительно можем

[37:47] => создавать службы развертывания и так далее на нашем Кластер Kubernetes. Но сначала давайте перечислим узлы

[37:54] => которые доступны в нашем кластере Kubernetes. Для этого, пожалуйста, введите команду cube CTL get

[38:01] => узлы. И здесь я вижу только один узел, потому что мини-куб создает кластер с одним узлом, он был

[38:09] => имя такого статуса узла готово. И вот они роли управляющего самолетом и ведущего. Мы это поймем

[38:17] => теперь внутри нашего мини-кубического кластера. Этот сингл узел действует как главный узел, так и рабочий узел и

[38:24] => на рабочем узле Kubernetes создает различные болты, связанные с вашими развертываниями, которые вы развертываете

[38:31] => в кластере Kubernetes. Теперь позвольте мне проверить, какой порты доступны или прямо сейчас в этом кластере.

[38:38] => Для этого давайте введем команду cube CTL получить модули, и теперь я вижу вывод без ресурсов

[38:45] => найдено в пространстве имен по умолчанию. Давайте перечислим все доступные пространства имен

[38:53] => теперь в этом кластере Kubernetes. Для этого, пожалуйста , введите команду cube CTL, чтобы получить такие пробелы в именах.

[39:01] => И я вижу несколько пространств имен, таких как куб по умолчанию пространства имен узла, общедоступного куба и системы кубов

[39:11] => используются в Kubernetes для группировки различные ресурсы и объекты конфигурации.

[39:18] => И если вы введете просто куб CTL получите капсулы, вы будете смотрите только порты, доступные внутри по умолчанию

[39:25] => пространство имен здесь. И, кстати, все порты, которые будет создавать повсюду баллы, будет здорово

[39:32] => в пространстве имен по умолчанию, но мы еще не создали никаких портов до сих пор. Вот почему давайте

[39:39] => попробуйте выяснить, какие порты работают внутри других наших пространств имен, например, cube system. В

[39:47] => чтобы перечислить порты в определенном пространстве имен, вы должны использовать опцию пространства имен. Итак, куб

[39:55] => CTL. Достань капсулы. Вот пространство имен, знак равенства , а здесь введите систему кубов. Давайте пойдем дальше и побежим

[40:02] => эта команда. И теперь здесь, в этом пространстве имен кубическая система, я вижу такие доски, как гордиан

[40:10] => etcd, в котором хранятся все журналы всего кластера Kubernetes, куба, сервера API, контроллера куба, куба,

[40:18] => прокси-сервер, расписание куба и поставщик хранилища. Все эти болты являются системными шариками, которые работают на

[40:25] => эта главная записка. Хорошо, вот как мы могли бы узнать, какие порты работают прямо сейчас в нашем

[40:33] => Кластер Kubernetes. Теперь давайте пойдем дальше и создадим оба вручную. И для этого мы могли бы использовать

[40:40] => команда, аналогичная команде запуска docker. Но с помощью команды docker run вы можете создать

[40:45] => просто один контейнер Docker здесь, или вы могли бы используйте команду cube CTL Run для создания

[40:52] => только один порт. Давайте сделаем этот пробег cube CTL здесь будет назван. Давайте, например, использовать nginx

[41:01] => Изображение докера, доступное в Docker Hub. Для этого давайте введем здесь имя порта Nginx.

[41:07] => А затем давайте добавим опцию image, и ее значение будет Ingenix Ingenix. Здесь

[41:14] => это имя изображения докера, которое будет автоматически извлечено и будет создан новый контейнер

[41:22] => на основе этого изображения и этого контейнера будет будет работать внутри порта Kubernetes.

[41:29] => Давайте пойдем дальше и посмотрим, что произойдет. Куб CTL Iran Ingenix делает это изображение знаком равенства

[41:35] => Ingenix и здесь я вижу выходной порт Ingenix. Здорово. Давайте введем команду cube CTL, чтобы получить банки.

[41:44] => И вот теперь я вижу, что однопортовый nginx еще не готов. И вместо него создали контейнер.

[41:54] => Давайте снова введем ту же команду cube CTL get pods , и теперь я вижу, что эта плата теперь запущена, это

[42:00] => готово, и оно имеет статус запущено. Конечно , для создания такого модуля потребовалось некоторое время, потому что

[42:08] => внутри него был контейнер nginx и докер внутри узла Kubernetes

[42:15] => на самом деле было запрошено извлечь изображение nginx из Концентратор докеров и создайте соответствующий контейнер

[42:23] => на основе поискового изображения Ingenix. Дайте нам знать , узнайте подробности об этом конкретном порту.

[42:30] => по имени Nginx. Это имя мы указали здесь вручную. Для этого, пожалуйста, введите команду cube CTL

[42:38] => опишите порт, и здесь будет название порта, который вы хотели бы описать, чтобы получить подробную информацию о

[42:46] => здесь будет Ingenix. Это имя порта запуска. И есть много разных деталей, связанных с

[42:52] => этот конкретный порт. Позвольте мне прокрутить немного вверх. И здесь я узнаю такую информацию, как пространство имен

[43:01] => этот порт принадлежит и был автоматически назначен пространству имен по умолчанию. Вот почему мы были

[43:08] => смогли увидеть это в списке, когда мы ввели команду cube CTL получить модули, потому что такие списки команд

[43:16] => все они находятся внутри пространства имен по умолчанию. Вот информация об узле, где находится такой конкретный порт

[43:24] => было создано или сохранено, что Kubernetes автоматически распределяет нагрузку по всем узлам рабочие узлы

[43:31] => внутри кластера, и он выбирает конкретный узел для конкретного содержания доски информация о

[43:38] => узел, на котором был создан этот конкретный порт. В нашем кластере с одним узлом, конечно, вы будете

[43:45] => смотрите один и тот же узел каждый раз, когда вы создаете какой-либо порт, и вот IP-адрес такого узла

[43:52] => здесь с указанием времени запуска указаны метки статуса запущено. А вот адрес B, который

[43:58] => был приписан к этому конкретному порту 172 17 03. Но, пожалуйста, знайте, что теперь мы

[44:06] => не сможет подключиться к этому конкретному порт, использующий такой внутренний IP-адрес или порт.

[44:13] => Чтобы иметь возможность подключаться к портам, вы должны создавать сервисы в Kubernetes.

[44:18] => И это то, что мы рассмотрим немного позже. Здесь или ниже вы также можете узнать, какие

[44:24] => контейнеры были созданы внутри этого порта. И здесь был только один контейнер, который был

[44:31] => такого контейнера здесь был длинный идентификатор здесь было изображение который был использован для этого конкретного контейнера.

[44:38] => И это то изображение, которое было указано с помощью опции dash dash Image при создании нового порта.

[44:45] => Здесь был идентификатор изображения, и это идентификатор изображения из концентратора докеров, потому что по умолчанию Kubernetes тянет

[44:52] => все изображения из концентратора докеров. Конечно, можно настроить Kubernetes для извлечения изображений

[44:58] => из других репозиториев. Службы записи, но по умолчанию это Докер-хаб. Хорошо, это рассказы о

[45:06] => этот конкретный порт. И мы узнаем, что этому порту был назначен адрес B, был

[45:13] => контейнер, который был создан внутри этого порта. И вот журналы, связанные с созданием этого

[45:20] => конкретный порт. Вы видите, что этот конкретный порт был успешно назначен на минуту, которую вы отмечаете здесь

[45:27] => было сообщение о том, что движок изображений X из концентратора докеров успешно извлек созданный образ

[45:34] => Контейнерный движок X и запустил контейнер Ingenix. А это значит, что теперь появился контейнер nginx

[45:42] => работает внутри сетевого порта. Опять же, вы можете найти список всех лодок, введя команду

[45:48] => cube CTL получает модули, и здесь была одноплатная плата , доступная прямо сейчас в пространстве имен по умолчанию. Сейчас,

[45:57] => давайте быстро вернемся снова внутрь Узел мини-куба Kubernetes и, наконец, снова,

[46:04] => Контейнеры Docker, и мы обнаружим, что теперь появился еще один контейнер, который был создан

[46:10] => в экспорте двигателя. Поэтому, используя стрелку вверх, я мог бы вернитесь к команде SSH, которую я ввел ранее.

[46:18] => Вот он и снова подключитесь к этому узлу. Входить Пароль пользователя TC. И давайте введем сюда докера

[46:26] => ps. Но теперь давайте отфильтруем вывод по имени ngi NX. И теперь я узнаю, что есть два

[46:36] => разные контейнеры здесь был первый, а вот второй, которые связаны с двигателем X.

[46:45] => Вот название контейнера для тяги, Высоты nginx nginx по умолчанию и так далее.

[46:52] => А также там был еще один контейнер GAE восемь спортивных nginx по умолчанию и так далее.

[46:59] => И этот второй контейнер называется контейнер для патронов. Вот вы видите, что

[47:04] => внутри контейнера , в котором фактически был запущен исполняемый файл, один контейнер был оценен

[47:12] => и если Dogra — это среда выполнения контейнера в Kubernetes, всегда есть такие оба контейнера,

[47:20] => которые создаются для каждого конкретного порта. И такие почтовые контейнеры создаются для того, чтобы

[47:28] => допустим, посмотрите пространство имен определенного порта. И мы уже обсуждали, что все контейнеры внутри

[47:35] => одной и той же платы фактически разделяют пространства имен. И этот контейнер, который на самом деле запущен в нашем nginx

[47:43] => веб-сервер будет остановлен, может быть воссоздан с помощью Кубернетес. Но и то, и другое остается нетронутым. И это

[47:52] => второй контейнер, который называется контейнером boss , необходим для сохранения пространства имен порта.

[47:59] => Хорошо, вот как сейчас выглядят контейнеры. И давайте на самом деле подключимся к этому контейнеру

[48:07] => где мы запускаем службу nginx. В порядке для подключения к контейнеру вы можете использовать любой идентификатор

[48:13] => этот или это имя. Давайте подключимся к контейнеру по этому идентификатору, пожалуйста, выберите это

[48:20] => контейнер примечание: приостановите контейнер. И давайте введем команду Docker Exec. Это удостоверение личности здесь было удостоверением личности

[48:30] => контейнер. И давайте соединим этот контейнер с помощью Исполняемый файл SHA. Теперь я внутри контейнера.

[48:37] => Давайте проверим его имя хоста. Гениальный. На самом деле это название правления. И было присвоено то же имя

[48:46] => к этому контейнеру. И давайте также проверим IP адрес этого контейнера вот такой адрес был 172 17

[48:54] => 03. И это тот IP-адрес, который мы видели в деталях порта. Теперь давайте попробуем

[49:01] => подключитесь к веб-серверу, который работает внутри этого контейнера, в котором мы сейчас находимся, используя

[49:07] => этот IP-адрес. И для этого мы могли бы использовать команду see URL, а здесь основаны на IP-адресе

[49:14] => из этого конкретного контейнера. Как бы то ни было, мы находимся внутри контейнера nginx.

[49:20] => Давайте попробуем установить связь. И вот я вижу Добро пожаловать на страницу nginx, которая была возвращена этим

[49:28] => веб-сервер. Это означает, что веб-сервер nginx запущен и работает. Давайте выйдем из этого контейнера и

[49:37] => сейчас мы все еще находимся внутри узла Kubernetes. Хорошо, но мы подключились к нему по SSH. И теперь

[49:43] => давайте так же выйдем из этой связи. А теперь давайте введем следующую команду cube CTL

[49:50] => получите модули, которые все белые, и с помощью такой опции вы также найдете IP-адрес конкретного

[49:58] => порт в этом выводе — тот же IP-адрес, который мы только что видели внутри контейнера.

[50:06] => Давайте теперь попробуем подключиться к такому адресу P с нашего компьютера, наш компьютер является внешним по отношению к

[50:15] => наш кластер Kubernetes, потому что узел Kubernetes работает внутри виртуальной машины.

[50:20] => И этот IP-адрес был назначен докером к определенному контейнеру внутри узла.

[50:28] => Давайте попробуем подключиться к такому IP-адресу, я мог бы используйте ту же команду CRL. Здесь он доступен

[50:35] => на Mac. Или вы можете просто открыть веб-браузер и подключиться к этому IP-адресу. И ты найдешь

[50:41] => выходит, что вы не сможете подключиться к контейнеру engine X таким образом. Потому что, как я уже сказал

[50:48] => вами ранее, такой IP-адрес является внутренним IP-адресом порта, и вы не можете подключиться к такому

[50:54] => портвейн извне выкатился за пределы классной комнаты. Здорово. Вот как мы создали самую первую доску в

[51:02] => наш кластер Kubernetes. И мы также исследовали хвост коммутатора. И я надеюсь, что теперь это так

[51:09] => вам ясно, что происходит, когда вы создаете доску внутри контейнера port Kubernetes grades.

[51:16] => И для того, чтобы создать контейнер, он должен извлечь изображение из концентратора докеров.

[51:20] => И в нашем примере изображение nginx было извлечено, и на основе этого изображения был создан новый контейнер.

[51:27] => Кроме того, мы зашли внутрь контейнера и убедились , что веб-сервер nginx теперь действительно запущен.

[51:35] => Но мы не можем подключиться к такому порту извне , потому что теперь у него есть только внутренний IP

[51:41] => адрес, который был назначен докером. Но , конечно, создание порта с использованием cube CTL Выполняется

[51:46] => команда не очень удобна, потому что вы не способен масштабироваться. И, например, увеличить

[51:53] => количество портов, был только один порт, который мы создали с помощью команды cube CTL Run.

[51:59] => Вот почему теперь давайте просто удалим созданный порт, для этого есть команда cube CTL Delete.

[52:07] => Далее будет название ресурса, который мы хотели бы удалить и Диспорт, и там будет имя

[52:12] => порта в нашем примере Ingenix, потому что мы указали имя сайта для порта вручную, когда

[52:19] => мы ввели команду запуска cube CTL. Так что давайте идите дальше и удалите порт, купленный Ingenix

[52:27] => удалено, cube CTL получает модули, и в пространстве имен по умолчанию не найдено ресурсов и такого порта

[52:35] => просто исчез. И все тома все пространства имен связанные с этим конкретным портом были удалены.

[52:45] => Здорово. Вы могли заметить, что мы вошли в куб Команда CTL несколько раз и, на мой взгляд,,

[52:52] => такая команда относительно длинная. И мы способны создать псевдоним для такой команды, чтобы сохранить

[52:59] => когда-нибудь в будущем. И мы могли бы использовать псевдоним преобразуйте команду CTL всего в одну букву K.

[53:06] => А затем мы введем такие команды, как K получить порты. Но теперь, если я введу команду поиска,

[53:12] => Я получу команду не найдена ошибка потому что я еще не создал никаких псевдонимов.

[53:18] => В операционных системах, подобных Linux, вы можете очень легко создавать псевдонимы, введя псевдоним команды.

[53:26] => Далее будет псевдоним для команды, затем знак равенства, а после знака равенства в двойных кавычках вы

[53:32] => можете написать команду, которую вы хотели бы использовать под псевдонимом в нашем примере cube CTL, если вы являетесь пользователем Windows

[53:39] => и если вы используете PowerShell, эта команда будет не работать там. Если вы хотите получить аналогичное

[53:47] => мой опыт работы в командной строке, я рекомендую вам установить Git Bash. Для того, чтобы установить

[53:53] => это, пожалуйста, перейдите, чтобы получить SCM-связь и просто скачайте Git. Если get уже установлен на вашем

[54:00] => Компьютер с Windows, у вас уже есть доступ к Git Баш, это еще один терминал. Если у вас нет

[54:07] => Установлен Git пожалуйста, перейдите в раздел Windows здесь и скачайте git для Windows, есть разные

[54:14] => ссылки, чтобы поесть. И после установки, пожалуйста, откройте Терминал Git Bash вместо powershell. Так

[54:22] => У меня уже есть команда псевдонима, доступная в этом терминале на Mac OS. Поэтому я смогу

[54:28] => чтобы создать такой псевдоним, давайте создадим LS Был создан LS, и теперь я могу использовать только короткий

[54:35] => версия команды K получает модули, и теперь я вижу , что в пространстве имен по умолчанию не найдено ресурсов.

[54:42] => С этого момента я буду использовать такую короткую версию команды cube CTL